2024网络交换机行业分析报告

1Transformer架构下的智算算网新需求

2017年谷歌发布《AttentionIs All You Need》,Transformer模型引入注意力机制(attention),用于学习不用位置的词汇之间的关联关系,从而更好表征大型语言文本中的语义和词法的关系。而作为Transformers的自然语言处理模型之一,GPT通过使用Transformer的解码器左到右建模文本,从而确保生成的文本是来自上下文的正确表示。2022年11月底,OpenAI公司上线一款具有跨时代意义的大模型智能语言模型ChatGPT,生成式语言类大模型自此大放异彩。随着大模型的能力被广泛认知,对模型效果优化的相关研究逐步加速。根据OpenAI的《Scaling Laws for Neural Language Model》,适当扩大模型参数量,语言模型的生成及预测能力将会提高,但这一正向关系很大程度上受到计算约束的限制,即相同的计算约束下,总有最佳的模型参数量和最大的模型有效程度。因此,如何最大程度提高集群的计算约束成为新的核心议题。

集群的有效算力可以分解为GPU利用率、集群的线性加速比,GPU的利用率受制于芯片架构的制程、内存和I/O访问瓶颈、卡间互联带宽和拓扑、芯片功耗等因素,“集群线性加速比”则取决于节点的通信能力、并行训练框架、资源调度等因素。因而,如何设计高效的集群组网方案,满足低时延、大带宽、无阻塞的机间通信,从而降低多机多卡间数据同步的通信耗时,提升GPU有效计算时间比(GPU计算时间/整体训练时间)至关重要。基于中国移动研究院的《面向AI大模型的智算中心网络演进白皮书》,AI大模型对网络建设也提出了新的要求:1)超大规模组网:训练参数达到千亿-万亿级别的AI超大模型代表着超高速算力需求,并进一步对应着大量的硬件需求及与之匹配的网络可延展能力。根据《面向超万卡集群的新型智算技术白皮书》,当单集群中卡的数量达到万卡级别后,相应的,如何实现最优运算效率、最佳数据处理能力、硬件层面的万卡互联、网络系统的可用和易运维等,会成为AI智算中心的新议题。2)超高带宽需求:多卡构成的算力集群内,不可避免的存在服务器机内和机间通信。

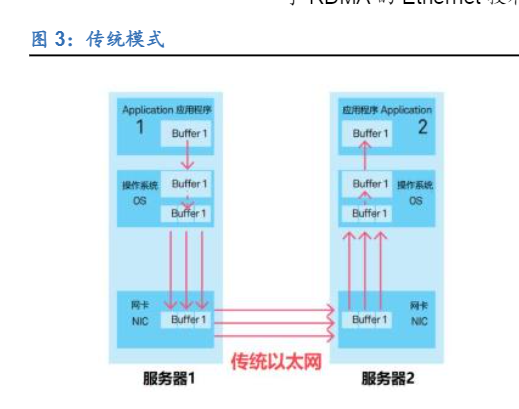

机内,模型并行产生的AllReduce集合通信数据量将达到百GB级别,因此机内GPU间的通信带宽及方式对于流完成时间十分重要。机间,流水线并行、数据并行及张量并行模式中部分集合通信亦将达到百GB级别,复杂的集合通信模式将在同一时刻产生多对一、一对多的通信,因此机间GPU的高速互联对于网络的单端口宽带、节点间的可用链路数量及网络总带宽均提出了高要求。3)超低时延:数据通信传输的时延分为静态和动态时延两个部分,静态时延由转发芯片的能力和传输的距离决定,当网络拓扑与通信数据量确定时,此部分时延通常为固定值。动态时延包含了交换机内部排队时延和丢包重传时延,通常由网络拥塞、丢包与网络抖动引起。4)超高稳定性与自动化部署:由于卡的数量大幅增加,网络的稳定性成为网络集群的“木桶短板”,网络故障及性能波动将导致计算节点间的连通性和计算资源的利用率均受到影响。RDMA((RemoteDirect Memory Access远程直接内存访问)可以降低多机多卡间端到端通信时延。在传统网络中,数据传输涉及多个步骤:首先将数据从源系统的内核复制到网络堆栈,然后通过网络发送。最后,在接收端执行多个步骤后,将数据复制到目标系统的内核中。RDMA可以绕过操作系统内核,让一台主机可以直接访问另外一台主机的内存。目前RDMA技术的主要采用方案有Infiniband和RoCEv2(基于RDMA的Ethernet技术,后简称为RoCE)两种。

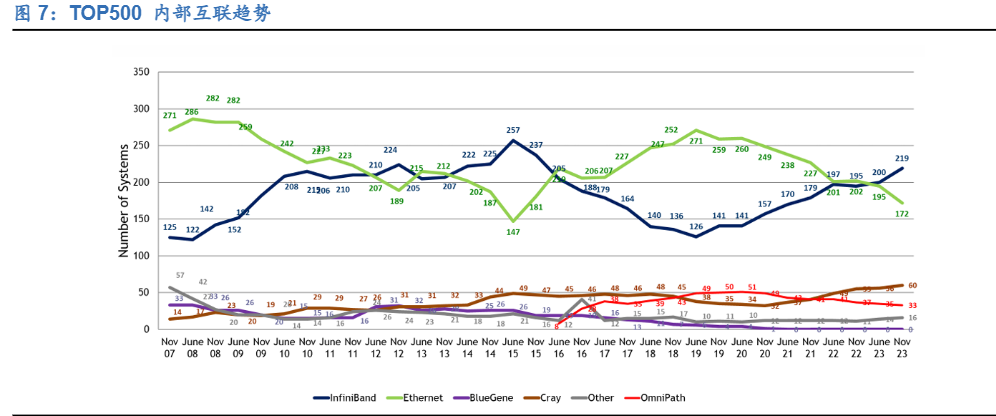

IB(Infiniband)和RoCE(基于RDMA的Ethernet技术)是目前主流的两种网络技术,IB架构的网络胜在低延迟及高带宽,以太网则优在开放性及性价比。RoCE是应用相对广泛,相对成熟的网络互联技术,也是整个互联网络大厦的基石,兼容性好,可实现不同的系统之间的互连互通。同时,RoCE的供应商较多,也因此具有相对较强的性价比优势。IB的应用领域很专,作为高带宽、低时延、高可靠的网络互联技术,在HPC集群领域广泛应用。但由于供应商较少,部署成本高于RoCE。

RoCE是足够好的方案,而InfiniBand是特别好的方案。不可否认的是,在超算集群中,IB架构仍是选择相对较多、效率相对较高的互联方式。虽然IB网络结构有性能优势,基于成本和开放性考虑,大多数云计算公司仍表示计划在其生产型人工智能基础设施中使用开源以太网交换机,而不是专有的IB解决方案。根据亚马逊的高级首席工程师Brian Barrett,AWS之所以放弃IB方案,主要是因为:“云数据中心很多时候是要满足资源调度和共享等一系列弹性部署的需求,专用的IB网络构建的集群如同在汪洋大海中的孤岛”。

当下大模型企业把更多的精力都花在提升大模型智能水平,因此绝大部分算力都被用在于训练。但随着模型迭代逐步放缓及更多AI应用的落地,推理侧的需要也在快速增加,而以太网设备由于其更具性价比或将是推理需求的首选方案。2023年7月19日,在Linux基金会的牵头下,由云厂商(MATA、微软),网络设备厂商(博通、思科、惠普),半导体公司(AMD、Intel)等业界各方力量参与的UEC联盟(UltraEthernetConsortium超级以太网联盟)成立。该联盟将提供基于以太网的开放、互操作、高性能全通信栈架构,以满足人工智能和高性能计算日益增长的大规模网络需求,因而我们认为UEC的成立有利于以太网架构在HPC等高性能计算领域的技术进步。在最新一季财报会上,Arista表示其与Broadcom 合作的集群数据显示,Arista的以太网产品,相比传统的InfiniBand,作业完成速度至少提高了10%。

2 IB:格局寡头,性能占优

2000年,IB架构规范的1.0版本正式发布。由于其最早引入RDMA协议,从而源生的具有低延迟、大带宽、高可靠的优势。2015年,InfiniBand技术在TOP500榜单中的占比首次超过了50%,达到51.4%(257套),InfiniBand 成为超级计算机最首选的内部连接技术。目前IB架构的供应商以Nvidia的Mellanox为主。IB协会(InfiniBand Trade Association,IBTA)最初由英特尔、微软、SUN公司、IBM、康柏以及惠普公司主导成立。1999年5月,Mellanox由几名从英特尔公司和伽利略技术公司离职的员工,在以色列创立,并于2001年推出了自己首款IB的产品。2002年,原IB阵营的巨头英特尔和微软退出。2010年,Mellanox和Voltaire公司合并,IB主要供应商只剩下Mellanox和QLogic。2012年,英特尔以1.25亿美元的价格收购了QLogic的IB网络业务重回IB阵营,但不久又以1.4亿美元的价格从Cray手中收购了“Gemini”XT和“Aries”XC超级计算互连业务,后基于IB和Aries打造出了新的Omni-Path互联技术。2013年,Mellanox相继收购了硅光子技术公司Kotura和并行光互连芯片厂商IPtronics,进一步完善了自身产业布局。2015年,Mellanox在全球InfiniBand市场上的占有率达到80%。2019年,英伟达(Nvidia)公司击败对手英特尔和微软,以69亿美元的价格成功收购了Mellanox。

我们以英伟达最新一代GB200产品为例:2.1机柜内部单个rack内部包括18个Computetray(上10下8)和9个Switchtray,机柜内Computetray和Switch tray之间通过CopperCableCartridge相连。通过液冷冷却体系,相较H100的风冷基础设施,在相同的功耗下可以实现25倍的性能。

单个Computetray包括2颗GB200 Grace Blackwell Superchip、4颗Connectx-800G Infiniband Supernic 及1颗Bluefield-3 DPU。1)GB200 Grace Blackwell Superchip包含两颗Blackwell GPU和一颗Grace CPU。其中,单颗BlackwellGPU架构尺寸是上一代HopperGPU的两倍,但AI性能(FP4)是Hopper的5倍(单颗BlackwellGPUAI性能(FP8)约为20petaFLOPS,8X24GB的HBM3e,8TB/s的内存带宽),有18个NVlink端口连接18颗NVlinkswitch chip,实现1.8TB/s双向连接速度。2)Connectx-800G Infiniband Supernic可以实现端到端800Gb/s的网络连接和性能隔离,专为高效管理多租户生成式AI云而设计,通过PCIe 6.0提供800Gb/s的数据吞吐量。ConnectX-8 Supernic支持单端口OSFP224和双端口QSFP112连接器,支持NVIDIA Socket Direct16 通道辅助卡扩展。3)Bluefield-3 DPU可以通过400Gb/s 以太网或NDR 400Gb/s InfiniBand 网络连接,以实现卸载、加速和隔离软件定义的网络、存储、安全和管理功能,从而显著提高数据中心的性能、效率和安全性。

单个Switchtray包括2颗NVlinkSwitch芯片,单颗Switch芯片单颗芯片支持4接口、单接口1.8TB/s的传输速率。每个Switchtray盘可提供144个NVlink端口(100GB),14.4TB/s的总带宽。9个Switchtray盘,可以提供9*144=1296个端口,完全连接72个Blackwell GPU上单颗18个,共72*18=1296个NVlink端口。

机柜内连接方面,Computetray和Switchtray之间通过五代NVlink相连,五代NVlink双向带宽为1.8 TB/s,是上一代的2倍,是PCIe Gen5带宽的14倍以上。1.8TB/s的GPU-to-GPU间通信,使得AI及高性能计算中GPU的扩展成为可能。Computetray中Superchip内部GPU及CPU间通过NVlinkChip-to-Chip连接(双向带宽900GB/s)。

2.2 机柜之间GPU=72在现有硬件配置下,单台机柜内部通过NVlink即可实现L1层switchtray连接:1)铜缆为GB200机柜内首推方案。虽然GB200通过充分提升单芯片的算力密度、应用散热效率更高的液冷方式,实现了在更小的空间内部署更多的GPU卡,使铜缆连接成为机柜内连接更具性价比的方案。但基于高速率长距离的传输损耗问题,未来迭代节奏与应用的持续性仍有待观察。GPU>72在现有硬件配置下,单层网络已无法满足要求,需升级至更高层数网络结构。有单一NVlink、IB组网:1)当所需连接的GPU数量大于72小于576时,在NVlink单一组网的方案中,可以使用架构为全NVlink连接的集群,GPU和光模块的数量比例为1:9。单机柜的NVL72方案中的交换机已没有额外的接口进行更大规模的互联,根据推荐,可扩展集群多采用双机柜NVL72方案,单个机柜有18个ComputeTray、9个SwitchTray。与单机柜版本不同的是,双机柜版本ComputerTray仅一颗Grace Blackwell Superchip(2BlackwellGPU+1 Grace CPU)。SwitchTray内容单双机柜版本保持一致。36颗Blackwell GPU充分连接18颗NVswitchchip共有36*18=648个ports,构成576集群的为双排的16个机柜,则累计需连接的端口为648*16=10368个ports,单口单向速率为50GB/s(双向速率100GB/s)。假设L1至L2层网络通过光模块且采用1.6T光模块(200GB/s),则共需要10368*50/200*2=5184个1.6T光模块,GPU:1.6T光模块=576:5184=1:9。2)当所需链接的GPU数量大于72时,在IB组网的方案中,若使用最新一代NVIDIA Quantum-X800 Q3400交换机互联,根据端口数的不同,同样网络层数所能承载的最多GPU数量不同,GPU和光模块的比例略有区别。相较NVIDIAQuantum-2 QM9700仅有的64个400G的ports而言,最新一代NVIDIA Quantum-X800Q3400交换机有144个800G的ports,最多可以实现(144^2)/2=10368张GPU的互联。根据SemiAnalysis的预测,2层网络架构的1.6t光模块/GPU的比例在2.5左右,3层网络架构的1.6t光模块/GPU的比例在3.5左右。

3Ethernet:格局多竞争,开放占优

在Ethernet架构的网络中,以太网交换机是核心设备之一。基于以太网进行数据传输的多端口网络设备,每个端口都可以连接到主机或网络节点,主要功能就是根据接收到数据帧中的硬件地址,把数据转发到目的主机或网络节点。

3.1 下游:数据中心是核心驱动,需求呈量、速双增

按下游应用分,交换机可以分为数据中心(智算+企业+运营商)和园区等需求领域。智算或超大型数据中心领域交换机将充分受益于云计算技术的成熟及算力需求推动的传续效率提升。云计算、大数据、物联网、人工智能等技术产业发展提升了对数据流量及速率的需求,全球传统数据中心数量及占比持续提升,推动交换机需求数量增长。与此同时,生成式大模型等新兴产业推动智算算力需求爆发,智算数据中心间及内部互联带宽压力加大,网络架构升级,端口速率也从10-100Gbps提升至100-800Gbps。企业网数据中心交换机主要由于互联网行业近两年持续的颓势影响投资,运营商数据中心交换机自2022年以来保持建设高涨,集采、网络云、IT云建设持续进行。园区交换机同比下滑0.5%,先后经历过2021年供应链紧张时期的囤货大涨、部署消耗的低迷等待,目前已经进入到正常建设节奏。2023年园区交换机市场受到宏观经济波动影响更为明显,企业考虑到自身效益和生存压力,项目部署多有延迟。2024年随着宏观经济好转,园区交换机部署节奏有望转向正轨,并且随着Wi-Fi 6 AP的日益普及,也刺激了园区交换机需求增长。

3.2 中游:品牌+制造服务商,白盒的软硬件解耦为新趋势

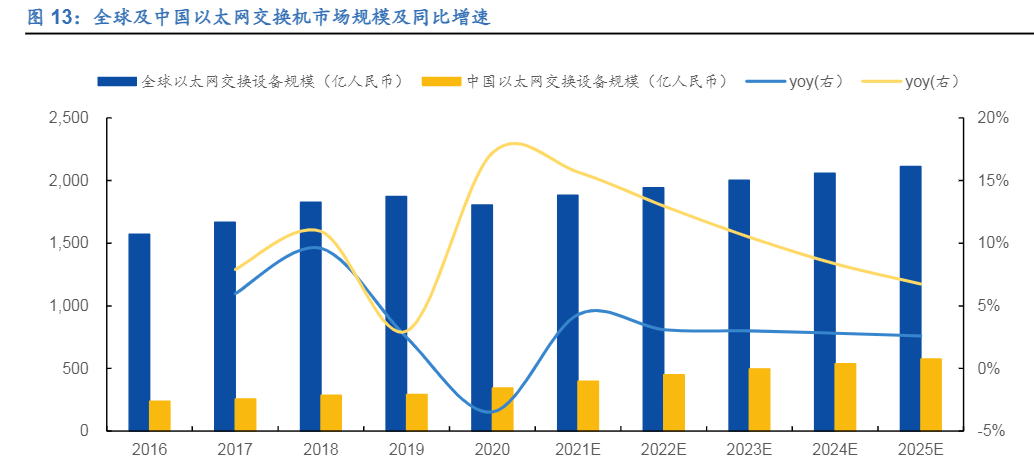

受数据传输量及速度需求支撑,全球以太网交换设备市场规模在2020-2025年间将实现3.2%的复合增长率。中国以太网交换设备市场则充分受益于国产替代契机,2020-2025年间复合增长率将高于全球平均水平,达到10.8%。

特征一:交换机制造环节的参与者分为品牌商和制造服务商,不同产业分工形成不同的格局。随着全球电子制造行业的不断发展,整个产业链逐渐呈现出品牌商和制造服务商专业化分工的行业格局。品牌商为了迅速扩大产能、降低生产成本及缩短新产品开发周期,逐渐把产品生产制造和开发设计环节外包,其业务重心转向新产品开发、品牌管理与市场营销,因此,电子制造服务行业应运而生。

(本文仅供参考,不代表我们的任何投资建议。如需使用相关信息,请参阅报告原文。)