2024半导体行业报告:AI创新驱动成长新周期

AI真的“狼来了”

AI的发展历程

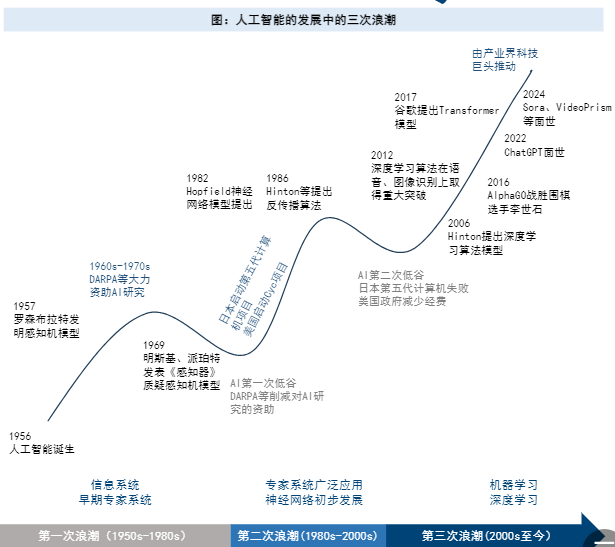

AI的诞生。1950年,艾伦•图灵(AlanTurin)写了论文《计算机器与智能》,提出图灵测试用来检测机器智能水平;1956年,美国达特茅斯学院举行了历史上第一次人工智能研讨会,被认为是人工智能诞生的标志。lAI诞生后经历了三次浪潮,我们认为,前两次主要由政府和科研单位推动,第三次主要由产业界推动。

为什么是现在?量变带来质变,AI已到临界点。Ø数据量:移动互联网时代,数据量快速增长。根据IDC的数据,2010年底全球数据量为1.2ZB,2022年突破100ZB,增长了近百倍。Ø算力:2006年,英伟达发布首个通用GPU架构Tesla,采用CUDA架构,GPU从专用图形处理器转为通用数据并行处理器;2012年AlexNet用两块GTX580GPU赢得了ImageNet图象识别大赛,英伟达日益加大CUDA投入;2022年英伟达推出的H100SXM5FP32单精度算力为60TFlops。Ø算法:各类深度学习框架和模型推出。

半导体技术是AI背后的功臣。过去三十年AI的重大里程碑都是由当时的先进半导体技术实现的,比如赢得ImageNet竞赛的GPU使用了40nm技术,AlphaGo征服围棋游戏使用28nm技术,ChatGPT的初始版本采用5nm技术。

算力、存力是AI的基础,先进封装为其助力

AI大模型所需算力大幅增加

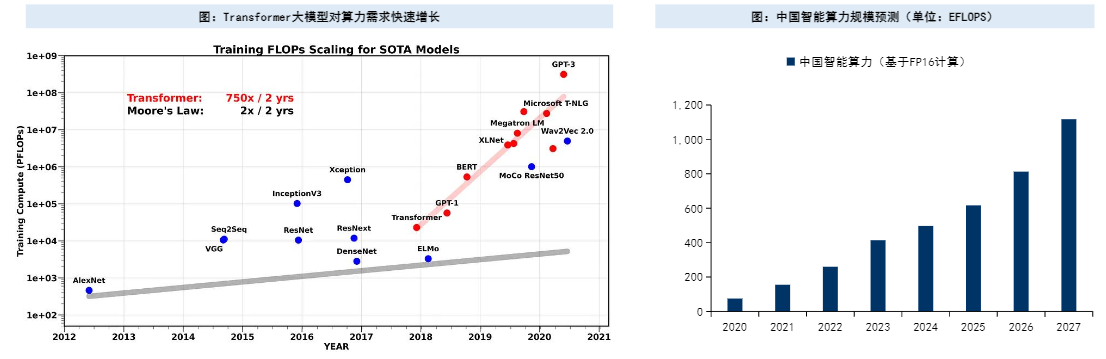

Transformer类AI大模型所需算力平均每2年增长750倍,对计算芯片的算力提出了极高的要求。l智能算力是面向人工智能应用,提供人工智能算法模型训练与模型运行服务的计算机系统能力。Ø根据中国信通院数据,2022年全球算力总规模达到906EFLOPS,其中智能算力(FP32)为451EFLOPS。Ø根据IDC的数据,2022年中国智能算力(FP16)规模达259.9EFLOPS,预计2027年将增加到1117.4EFLOPS,CAGR达34%。

预计2024年AI服务器出货量165万台,美国四大CSP需求超6成。根据TrendForce的预测,2024年全球服务器整机出货量将增长2.05%至1365.4万台,其中AI服务器出货占比将提高至12.1%,出货量165万台。美国CSP主导对AI服务器需求,Microsoft、Google、AWS、Meta合计需求超6成。lAI服务器加速芯片以英伟达GPU为主,占比高达6-7成,CSP业者有扩大自研ASIC的趋势。

AI芯片主要包括GPU、FPGA、ASIC。AI芯片也被称为AI加速器或计算卡,是专门用于处理人工智能应用中的大量计算任务的模块,主要包括图形处理器(GPU)、现场可编程门阵列(FPGA)、专用集成电路(ASIC)等。l预计2027年AI芯片市场规模达1194亿美元。根据Gartner的数据,2022年全球AI芯片市场规模为442亿美元,预计2027年增长至1194亿美元。

GPU起于图形处理,兴于通用计算。GPU的推出最初是为了解决CPU在图形处理领域性能不足的问题;之后演变出GPGPU,增加专用向量、张量、矩阵运算指令,提高浮点运算的精度和性能,以满足AI等通用计算需求。lGPU架构持续演进。英伟达H100计算性能较A100提升约6倍;预计2024年将推出的基于Blackwell架构的B200算力是H100的5倍。

各领域存储容量均将增长,其中数据中心、工业、汽车增速较高。根据美光科技的预测,2021-2025年DRAM容量的CAGR为14-19%,其中数据中心、工业、汽车分别为28%、24%、40%;NAND容量的CAGR为26%-29%,其中数据中心、工业、汽车分别为33%、45%、49%

异构数据中心推动存储容量增加

异构数据中心存储容量数倍增长,预计2021-2030年数据中心存储TAM的CAGR为14%。异构计算系统是由CPU加上GPU/ASIC/FPGA等各种加速器构成的计算体统,以更优、更经济的解决计算任务,包括AI大模型。美光预计2025年服务器所需要的NAND和DRAM容量分别是2021年的3倍和2倍,2021-2023年总市场规模CAGR为14%。l所需存储容量和AI模型参数量正相关。

HBM可解决部分“内存墙”问题

AI发展中面临“内存墙”问题。内存墙问题既包括内存容量大小不足,也包括内存的传输带宽不足。Ø大语言模型Transformer参数量平均每2年增长410倍,但加速器DRAM内存每2年仅增长2倍。Ø过去20年峰值算力提高了90000倍(平均每2年3.0倍),DRAM带宽仅提高了100倍(平均每2年1.6倍),互联带宽仅提高了30倍(平均每2年1.4倍)lHBM可以满足算力芯片对内存带宽的需求。高带宽内存(HighBandwidthMemory,HBM)是通过TVS技术将DRAM裸片垂直堆叠的3DDRAM,与GPU一起封装以实现更高的传输带宽。相较于其他DRAM的集成方式,HBM存储单元外的导线短,数据传递速度快,损耗小。

HBM于2015年商用,技术不断迭代。2013年HBM被半导体行业标准机构JEDEC正式采纳,2015年AMDRadeonFury系列率先搭载SK海力士生产的全球首款HBM,之后HBM沿着HBM1、HBM2、HBM2e、HBM3演进,容量和带宽均明显提升。HBM3于2022年1月发布,并在H100中率先搭载。最新的HBM3e预计将在2024年下半年逐季放量。

HBM由SK海力士、三星、美光主导

HBM在DRAM产能和产值中的占比快速提升。根据TrendForce预计,2024年HBM需求位元增长近2倍,2025年有望再翻倍;预计2025年HBM占DRAM总产能的比例将超过10%;由于HBM单价高,预计2025年其占DRAM总产值的比例将超过30%。lHBM由SK海力士、三星、美光主导。根据TrendForce数据,2022年SK海力士、三星、美光HBM市占率分别为50%、40%、10%,集中度相对较高。截至2024年底,预计三星、SK海力士、美光HBM的产能分别为13万片/月、12+万片/月、2万片/月。

集成电路行业进入了“后摩尔时代”。集成电路制程工艺已接近物理尺寸的极限,进入了“后摩尔时代”。l从集成器件到集成小芯片。通过芯片异构集成,将传感、存储、计算、通信等不同功能的元器件集成在一起,可以突破光罩限制,进一步提高集成度,平衡计算性能、功耗、成本。比如台积电的CoWoS(Chip-on-Wafer-on-Substrate)技术可以容纳六个掩模版区域的计算芯片,及十几个高带宽内存(HBM)芯片。

CoWoS成为AI芯片的主要封装形式。台积电2008年底成立集成互连与封装技术整合部门,2011年推出CoWoS封装技术,2013年在赛灵思28nm的FPGA上量产,之后随着AI的发展被大量采用,包括英伟达H100和AMDMI300,通过CoWoS将GPUDie和HBMDie集成在一起。lTSV技术是HBM的核心。HBM通过3DTSV(硅通孔)技术将多层DRAMDie堆叠起来。l台积电扩产CoWoS。台积电表示,2023-2026年公司CoWoS产能将以60%的CAGR增长。TrendForce预计2024年底台积电CoWoS月产能将接近40K,2025年规划总产能接近翻倍。

预计2022-2028年高性能封装市场规模CAGR达40%。根据Yole的预测,高性能封装市场规模将从2022年的22.1亿美元增长至2028年的167亿美元,CAGR达40%。Ø按终端市场来看,2022年最大的下游是通讯/数据中心,占比超过60%;随着消费电子(含手机)以50%的CAGR增长,到2028年将成为第一大下游;2022-2028年CAGR最高的下游是汽车,达72%。Ø按技术来看,3D堆叠存储(包括HBM,3DS,3DNAND)占比最大,预计2028年贡献70%;2022-2028年增速较高的是3DSoC、有源硅中介层、嵌入式硅桥和3DNAND堆栈。

AI应用落地对半导体的推动将更为长远

AI应用落地对半导体的推动将更为长远

2023年英伟达CEO黄仁勋提出“我们正处于AI的iPhone时刻”;2024年又提出AI已到“TippingPoint”。l我们认为,AI对人类的影响更甚于过去的通讯技术、互联网技术。在AI基建和大模型算法的良性循环下,我们认为AI的应用将逐渐落地,从特定人群使用走向千家万户。通讯技术催生出了手机,互联网技术催生出了电脑和智能手机,AI除了赋能现有终端外,更可能使期待已久的人形机器人、自动驾驶汽车成为现实,或者催生出未知终端,赋能基础研究。

2023年全球智能手机出货量11.6亿部,同比减少3%。根据IDC的数据,全球智能手机在2015年后结束高增长,2017-2023年间仅2021年实现同比6%的增长,2023年同比减少3%至11.6亿部。l1Q24全球智能手机出货量同比增长8%至2.89亿部。从短期季度数据来看,经过4Q22和1Q23两位数同比减少后,2Q23同比降幅明显收窄,3Q23至1Q24连续三个季度同比增长,1Q24出货量为2.89亿部,同比增长8%,环比减少11%。

2024年是AI手机元年

2011年10月,苹果在iPhone4S上推出第一个人工智能作品Siri。之后,AI在手机中的应用主要集中在语音助手、人脸识别、拍照美化等,模型参数量通常不超过1000万。l2023年大模型在手机端运行成为可能。2022年发布的ChatGPT参数量达17.5B,远超手机的能力。2023年,可在手机端运行的模型出现,比如Meta2月发布的大语言模型LLaMA包括7B/13B/33B/65B4种参数量;

谷歌5月发布的大语言模型PaLM2也包含4种不同参数量,其中参数量最小的Gecko模型可以在手机上运行,即使不联网也能正常工作,且运行速度足够快;3月,高通利用骁龙平台的AI软件栈,首次在Android智能手机内运行了参数超过10亿的StableDiffusion模型。l2024年是AI手机元年。OPPO首席产品官表示“AI手机将是继功能机、智能机之后,手机行业的第三个重大的变革阶段”。集成大模型的手机将打破传统应用壁垒,成为用户真正的智能助手。

AI手机的用户价值:自在交互、智能随心、专属陪伴、安全可信的个人化助理。l预计AI手机渗透率将快速提升。IDC预计2024年全球新一代AI手机的出货量将达到1.7亿部,约占智能手机整体出货量的15%。其中中国市场新一代AI手机在2024年的出货量将达到3700万台,2027年达到1.5亿台,所占市场份额超过50%。

AI手机为半导体带来哪些变化?Ø处理器性能提高。手机是多模态设备,除了处理文本外,也需要处理图像、视频,算力需求会增加。2023年10月高通发布的骁龙8Gen3支持运行100亿参数端侧大模型;2023年11月联发科发布的天玑9300支持运行10亿至330亿参数的端侧大模型。Ø内存容量和带宽提高。在端侧跑13B大模型需要13GB的内存,再加上操作系统需要的内存,预计未来AI手机的基础配置将达到16GB或更高;另外,端侧运行13B大模型需要的内存带宽达130GB/s,比现有旗舰机的配置翻倍不止。因此,内存的容量和性能均需要提升。Ø功耗管理需求增加。虽然目前AI手机的电源管理芯片没有看到明显的需求变化,但我们认为,随着AI功能的使用增加,大模型运算会导致功耗变大,对负责能耗管理/充电管理的电源管理芯片在数量或性能方面也将提出新的需求。

2023年全球PC出货量2.6亿台,同比减少14%。根据IDC数据,全球PC出货量的高点在2011年,达3.6亿台;2012-2023年仅2020/2021年由于在线办公学习需求增速达两位数;2023年同比减少14%至2.6亿台,回到了2012年以来的最底部。l1Q24全球PC出货量同比增长2%至0.60亿台。从季度数据来看,全球PC出货量自1Q22以来持续同比下降,1Q24同比转正,同比增长2%至0.60亿台,环比减少12%。

2024年也是AIPC元年

2023年英特尔启动AIPC加速计划,发布为AIPC而生的酷睿Ultra处理器。2023年10月,英特尔启动AIPC加速计划,将在2025年前为超过1亿台PC带来AI特性;2023年12月,英特尔在北京举办以“AI无处不在,创芯无所不及”为主题的2023英特尔新品发布会上发布了酷睿Ultra处理器,这是英特尔首款支持端侧部署AI模型的消费级处理器,除内置CPU和GPU外,还内置了英特尔专为AI处理需求研发的专业NPU模块。最大可支持20B量级的AI模型本地部署,对话、资料整理、答疑、文生图等功能都可以在不通过云端AI模型的情况下,完全由本地NPU进行运算生成。l2023年10月,高通推出骁龙XElite处理器,可在本地支持13B的大模型;2024年4月推出骁龙XPlus处理器。l2024年也是AIPC元年。各PC厂商基于英特尔酷睿Ultra处理器、AMD锐龙处理器和高通骁龙X发布AIPC;微软在2024年5月的新品发布会上推出Windows11AIPC(Copilot+PC);2024年5月苹果发布M4芯片,搭载该AI芯片的AIPC有望年底前亮相。

人工智能的需求正在爆发,AIPC是大模型普惠于人的首选终端。用户不仅需要公共的大模型服务,更需要专属自己的个人大模型,个人大模型的普惠要求和PC的承载优势完美契合,显示着PC将再一次承载技术普惠的历史使命,成为AI普惠的首选终端。l什么是AIPC?Ø英特尔和微软合作定义的AIPC:英特尔的酷睿Ultra处理器,该处理器内置神经处理器单元(NPU),用于处理AI工作负载;微软的人工智能聊天机器人Copilot;以及微软设置的“Copilotkey”键,用来唤醒Copilot体验。Ø联想提出的AIPC五大核心特征:1)内嵌个人智能体,实现多模态自然语言交互;2)内嵌由本地大模型和个性化本地知识库构成的个人大模型;3)全面标配CPU+GPU+NPU的本地混合AI算力;4)开放连接丰富的AI应用生态;5)提供设备级的本地化个人数据和隐私保护方案。

AIPC提高生产力,渗透率快速提升

AIPC的用户价值:通用场景下的个性化服务,提供即时、可靠的服务响应,更低的大模型使用成本,可信、安全的个人数据和隐私保障。相比于手机,PC在工作中承担了更重要的角色,AIPC可以显著提高生产力,比如AIPC能够更准确的理解用户的创作意图,掌握用户的历史创作习惯及个人风格,并通过调用多种模型和应用、互联网公共资源等方式共同完成任务创作。l作为生产力工具,AIPC的渗透将快于AI手机。IDC预计AIPC在中国PC市场中新机的装配比例将在未来几年中快速攀升,2024年超过50%,2027年达到85%。

AIPC为半导体带来哪些变化?Ø处理器集成CPU、GPU、AI引擎。为了满足AI端侧应用,目前AIPC处理器基本采用CPU+GPU+NPU(AI引擎)架构,其中CPU具有快速响应优势,适合运行较小工作负载并实现低延迟;GPU具有高吞吐量优势,适合需要并行吞吐量的大型工作负载;NPU具有高能效比优势,能够以低功耗处理持续存在、大量使用的AI工作负载,提高效率。预计未来处理器架构将随着需求而演变,性能、价格、能耗是重点。Ø存储容量和带宽提高。大模型运行需要更大的内存和带宽,而个性化需求和独立性需要更多的本地数据支撑,预计DRAM和NAND的需求均将明显增加。Ø功耗管理需求增加。随着AIPC处理器的算力提高,对应的大电流DCDC芯片需求将增加;为了控制整体的能耗,提高使用时间,对其他配套电源管理芯片在数量或性能方面也将提出新的需求。

大模型加速AI发展,真正智能的AIoT有望激发消费者需求。2017年“万物智能·新纪元AIoT未来峰会”在国内首次正式提出AIoT概念,天猫精灵、小爱同学等智能音箱也在同年推出并畅销一时。但由于智能程度有限,最终普及和使用未达最初预期。随着大模型的发展,真正智能的AIoT将提升消费者体验,有望重新激发需求。2023年11月华为发布的全屋智能5.0便是AIoT应用场景之一。lAIoT终端虽然单机半导体价值含量可能不高,但当普及终端数量足够多时,也将对半导体带来不少增量。

(本文仅供参考,不代表我们的任何投资建议。如需使用相关信息,请参阅报告原文。)