2024GPU算力服务行业报告:AI驱动增长与产业布局加速

1、业务:聚焦GPU算力服务,盈利整体呈增长态势

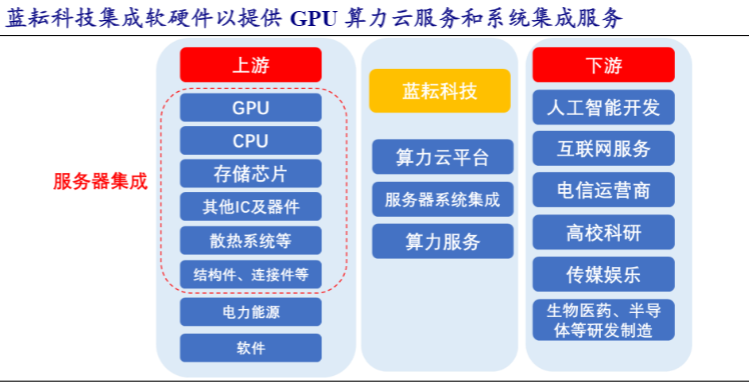

蓝耘科技是一家专注于为企业级规模的GPU加速工作负载提供算力云服务的公司,基于灵活的基础设施与大规模的GPU算力资源,为客户提供开放、高性能、高性价比的算力云服务。

公司成立于2004年,总部位于北京,在上海、广州、成都、厦门等地设有分子公司,于2017年挂牌新三板。公司拥有专业技术团队,从基础架构建设到云计算,从实施到售后,均有丰富的经验;已成为国家高新技术企业,北京市专精特新小巨人企业。

发展至今,蓝耘形成了以GPU算力解决方案为基础,GPU算力云服务为核心的业务版图,为相关高校、科研机构、生命科学、人工智能、自动驾驶、工业设计、智慧城市等领域有高性能计算需求的客户,提供低成本高质量的GPU算力云服务,满足客户业务应用和GPU算力随需扩展的双重需求。

1.1、产品:GPU算力业务占比持续提升,2023年毛利率达39.63%

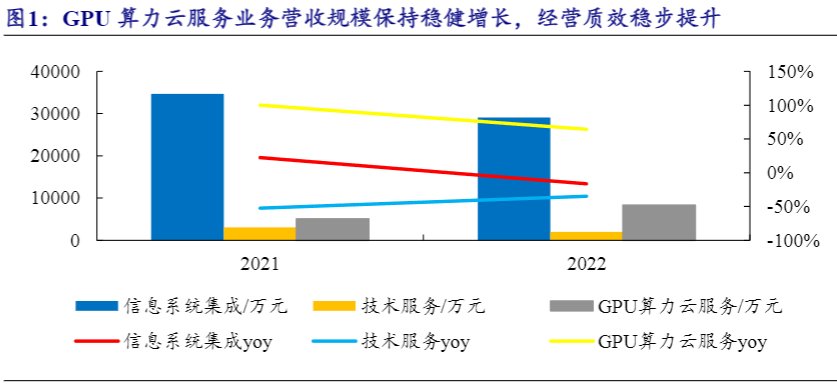

公司的主营业务为IT系统集成业务、技术服务业务、GPU算力云服务业务,其中GPU算力云服务业务自2021年以来高速增长,近年来占比不断上升,2023年公司算力云解决方案、GPU算力云服务业务稳步推进,其中算力云解决方案收入占比为66.14%,GPU算力云服务收入占比从2022年的21.16%稳步提升至33.86%,公司业务结构持续优化,GPU算力云服务业务营收规模保持稳健增长,经营质效稳步提升,且毛利率达到39.63%,高于公司传统的系统集成业务。

从业务内容来看,IT系统集成业务主要产品与服务包括企业私有云解决方案、容灾备份解决方案、高性能计算HPC解决方案以及分布式存储系统解决方案;技术服务业务主要包括IT系统运维服务,软件系统开发服务;GPU算力云服务主要是基于蓝耘GPU云IAAS基础设施,根据客户业务对CPU及GPU算力的需求,通过算力云平台为客户提供远程CPU或GPU多核并行算力,客户按需购买算力核时或卡时预付费给蓝耘科技。蓝耘算力云平台可以向用户提供虚拟化的计算资源、存储资源、网络资源等,这些资源能够根据用户的需求动态的分配。

1.2、商业模式:自建智算云平台,服务高性能计算需求行业龙头企业

蓝耘算力云业务以Iaas+Pass为基础架构,依托数据中心,交付给用户高效、灵活、可扩展的基础设施资源,用户无需购买、维护硬件设备和相关系统软件,就可以直接在蓝耘云平台上构建自己的平台和应用。蓝耘算力云平台可以向用户提供虚拟化的计算资源、存储资源、网络资源等。

这些资源能够根据用户的需求动态的分配。支撑该服务的技术体系包括虚拟化技术和相关资源动态管理与调度技术。蓝耘GPU算力云业务目标用户包括个人用户与企业用户,个人用户的算力云服务应用场景包括机器学习、计算机视觉、自然语言处理等AI领域的培训与学习,以及高校相关专业学生的毕业论文设计、科研项目基础研究等,涉及目标院系包括计算机、人工智能、物理化学、生命科学、环境科学、地理勘测、航空航天等。

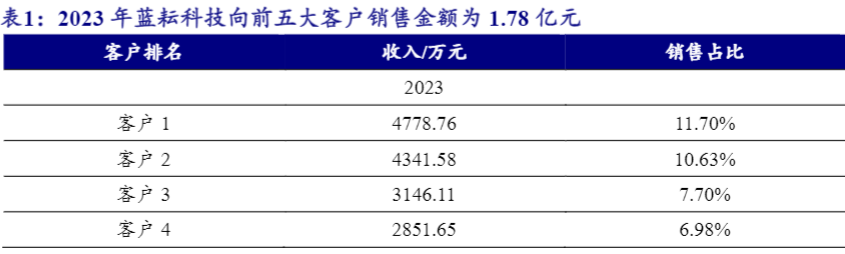

企业用户的算力云服务应用场景主要集中在自动驾驶、AI大模型、生命科学、工业设计以及教科研领域的大型科研项目等。2022-2023年,蓝耘科技向前五大客户销售金额分别为1.46亿元、1.78亿元,前五大客户收入占比分别为37.05%、43.57%。核心客户方面,公司系统集成业务的核心客户以数字化服务、数据服务、网络通信等领域的服务商和集成商龙头企业为主。

2022年,第一、第四和第五大客户,主要交易内容为服务器(配件)及安装服务,不直接提供算力服务;而2022年GPU算力云服务的主要客户包括第二大客户(软件和信息技术服务商)、第三大客户(科技推广和应用服务商,致力于开发全球最大的中文搜索引擎之一的ROI媒体平台)这类具有较大GPU算力加速需求的厂商。

经营模式方面,蓝耘目前正围绕GPU算力打造“系统集成及服务”+“算力资源”+“云服务”为一体的综合业务版图。业务流程来看,算力云服务平台是基于Kubernetes原生云设计,专为大规模GPU加速工作量身打造,搭载高可配置高可用的英伟达高端GPU系列,支持按需灵活计费、轻松调整存储容量及扩展容量,客户可直接线上付费购买算力资源、进行服务器租借并实现定制化服务等等;蓝耘科技以自建云平台为主,需要采购各类应用和基础软件。

此外,公司目前虽然系统集成业务收入占比最高,但承接的系统集成业务主要也是GPU服务器相关的IT系统集成,获取订单后由公司售前及商务人员配合根据客户需求进行拆单和选型,之后根据公司库存情况将需进行采购的部件向供应商下单采购。最后IT硬件到达公司仓库或客户现场后,由公司实施人员进行集成,集成部分工作较为简单,主要为软硬件的连接与调试;

公司把集成中的服务分块成标准服务,并通过视频或现场指导外包服务团队按标准提供服务的方式完成集成,最后完成客户交付。公司业务过程中向不同客户提供的都是高度相似的类标准化服务,供应链体系和商务体系较为完善,在人员配备(1-2人)上无需较大投入。采购项目方面,公司采购的主要为IT系统集成业务和GPU算力云服务业务项目所需的计算机信息系统相关的软件、硬件产品(如服务器、交换机、小型机管理控制台)、技术服务等;主要供应商包括戴尔、英迈电子、北京同方信息、联想、中铁信息工程等。

1.3、财务:2023年实现营收4.09亿元,归母净利润5128.17万元

公司营收和盈利规模稳定增长,成长性良好。受益算力建设需求,公司业务快速增长,2023年实现营收4.09亿元、归母净利润5128.17万元;2020-2023年3年营收CAGR为5.54%,归母净利润CAGR达到15.75%。公司算力云解决方案、GPU算力云服务业务稳步推进,蓝耘智算云平台于2022年4月正式上线,基于蓝耘云基础设备,面向高校、科研院所、企事业单位等高性能计算需求的客户,满足客户业务应用和GPU算力随需扩展的双重需求。另外2024年4月公司签订重大销售合同,合同金额为1.04亿元。

2021年公司业务开始结构性优化,着力发展高毛利率的GPU算力云业务,推动公司盈利能力快速上升,2023年毛利率上升至25.79%。期间费用率呈上升态势,2020-2023年,期间费用率分别为6.55%、6.70%、8.59%、12.80%,主要原因为公司业务规模扩大,营销费用及人员薪酬费用上升。净利率呈现上升趋势,2023年净利率达到12.38%。

2、行业:AI驱动算力云发展加速,IT系统集成需求增长

2.1、GPU算力云:我国AI服务器市场达91亿美元,智能算力需求高景气

近年来国内数字经济快速发展,云计算行业作为最重要的基础设施产业之一对下游增长起到关键的促进作用,据中国信息通信院发布的《中国算力发展指数白皮书(2022年)》测算,算力每投入1元,将带动3-4元的经济产出;而随着人工智能、数字孪生、元宇宙等新兴领域的崛起,各类算力需求规模正快速增长,其中GPU算力对应“智能算力”的主要部分,将首先受益发展。智能算力即人工智能算力,由GPU(图形处理器)、ASIC(专用集成电路)、FPGA(现场可编程逻辑门阵列)、NPU(神经网络处理器)等各类专用芯片承担人工智能场景应用的计算,在专门应用下具有性能更优、能耗更低等优点。

截至2022年年底,我国算力核心产业规模达到1.80万亿元,算力总规模达到180EFLOPS,居全球第二,近5年保持30.00%左右的年均增速,对GDP增长的拉动作用显著。随着AI人工智能、ChatGPT、OPENAI等应用不断涌现,智能算力规模急速攀升,具备海量数据并行计算能力、擅长加速计算处理的GPU算力需求持续高涨。

据国际数据公司IDC与浪潮信息联合发布的《2023-2024年中国人工智能计算力发展评估报告》显示,未来市场需求量也将会实现大幅度上升,预计2023年,中国人工智能服务器市场规模将达91亿美元,同比增长82.5%,2027年将达到134亿美元,五年年复合增长率为21.8%。

2022年中国通用算力规模达54.5EFLOPS,预计到2027年通用算力规模将达到117.3EFLOPS。2022年中国智能算力规模达259.9EFLOPS,2023年将达到414.1 EFLOPS,预计到2027年将达到1117.4 EFLOPS。预计2022-2027年期间,中国智能算力规模年复合增长率达33.9%,同期通用算力规模年复合增长率为16.6%。

智能算力在AI深度学习中的应用主要体现在以下几个方面:一是训练模型,深度学习模型具有复杂的结构和大量的参数,需要大量的计算资源进行训练,智能算力通过GPU、TPU等高性能的计算设备,加速深度学习模型的训练过程。二是推断推理,智能算力通过高性能计算设备和专门的推理芯片加速深度学习模型的推断过程,提高了模型的实时性和稳定性。

三是模型优化,通过智能算力可以对模型进行自动化的超参数调优、网络结构搜索、模型剪枝等操作,进一步提高模型的精度和效率。以计算机视觉为例,需要GPU加速作为算力基础,实现大量数据训练和AI模型训练,比如通过卷积神经网络技术进行图像分类、目标检测和图像分割等任务,从而达成图像分类和目标检测、人脸识别、图像生成和风格迁移、三维重建和虚拟现实、视频分析和行为识别等具体应用。

GPU芯片多用于图形图像处理、复杂的数学计算等场景,可较好支持高度并行的工作负载,常用于数据中心的模型训练,也可以用于边缘侧和端侧的推理工作负载。2021年中国仍以GPU为主实现数据中心计算加速,据IDC测算GPU市场占有率近90%,而ASIC、FPGA、NPU等非GPU芯片市场占有率超过10%,其中NPU芯片设计逻辑更为简单,常用于边侧和端侧的模型推理,并生成结果,在处理推理工作负载时,具有显著的能耗节约优势,因此增长较快。

从工作负载角度而言,据IDC数据,2021年中国数据中心用于推理的AI服务器占比已达57.6%,预计这一比例将在2026年提升至6成。伴随企业人工智能应用成熟度逐步递增,企业将把精力更多从人工智能训练转移到人工智能推理工作负载上,这意味着人工智能模型将逐步进入广泛投产模式,因此智算中心的基础设施规划和运营支出规划更加需要追求服务器利用率提升和性能利用率的提升,以实现更好经济性。

当下全球智能算力快速增长,据中国信通院数据,2022年底全球算力总规模达到650EFLOPS,其中通用算力规模为498EFLOPS,智能算力规模为142EFLOPS,超算算力规模为10EFLOPS;智能算力规模同比增长25.7%,规模占比达21.9%。国内市场方面,2022年算力总规模为180EFLOPS,排名全球第二,其中通用算力规模为137EFLOPS,智能算力规模为41EFLOPS,超算算力规模为2EFLOPS。

中国智能算力同比增长41.4%,规模占比达22.8%。而2023年10月工业和信息化部、中央网信办、教育部、国家卫生健康委、中国人民银行、国务院国资委等六部门联合印发《算力基础设施高质量发展行动计划》,提出到2025年实现国内算力规模超300EFLOPS,其中智能算力占比达到35%(105EFLOPS),预计2022-2025实现36.8%CAGR。

智算需求增长背景下,云计算服务能提供更丰富的算力支持,如百度、腾讯、阿里等互联网巨头及蓝耘科技这类专门服务商通过aaS(asaService)服务提供AI平台和AI服务,从而实现快速的产品迭代能力和丰富的场景化人工智能能力。

据IDC数据,2021年国内人工智能公有云服务市场规模达到44.1亿元人民币,占整体人工智能软件市场的13.4%,增速远超人工智能软件整体市场增速;2022年在AI市场整体遇冷背景下,国内人工智能公有云服务市场规模增长80.6%至79.7亿元,计算机视觉占据约一半市场份额。另一方面,IDC也预计AI私有化部署仍是市场主流。

2.2、IT系统集成:市场结构变迁,AI、边缘等服务器增量持续驱动

蓝耘科技长期从事系统集成业务,在数字化产业链中处于基础层的方案解决商地位,主要受到服务器建设和数字化转型等下游需求驱动;近年来AI服务器建设需求增长背景下,蓝耘也更多将系统集成业务向GPU服务器切入,与自身算力业务打造资源和技术积累上的协同。

系统集成行业具备较强的综合性,其中IT设备的部署与集成服务需要基于行业客户的数字化转型等实际需求,结合厂商自身服务经验,通过先进的架构设计、硬件整合和方案设计、电源和散热等辅助设备优化等综合解决方案能力来帮助客户打造高效、安全可靠、绿色的数字基础设施。

从服务器的系统集成类型来看,传统市场以通用服务器为主,主要需求来自互联网、金融、工业、通信等领域对数据处理和运算有较高需要的大型公司对数据中心的建设;而目前AI服务器需求涌现,服务器集成需求增量从CPU向GPU切换,AI服务器系统集成市场有望迎来整体增量及格局变迁。

随着人工智能产业化加速,IDC数据显示2021年全球AI服务器市场同比增长39.1%,其中中国市场增长至59.22亿美元。预计到2026年,全球人工智能服务器市场将达到347亿美元,将占整个服务器市场的21.7%,较2022年的16.6%占比持续提升,且中国市场预计将达123.38亿美元。

据IDC数据,2021年浪潮信息、戴尔、HPE分别以20.9%、13.0%、9.2%的市占率位列全球前三,三家厂商总市场份额占比达43.1%。另一方面,以端(智能终端/物联网)-边(边缘计算)-云(云计算)-网(5G和高速光纤网络)-智(行业智能)为核心的新型IT技术架构不断完善,边缘计算已经成为当下重要的业务模式,其中包括基础设施边缘和设备边缘等概念。作为边缘计算基础设施的服务器建设也将随之发展,尤其受云网边端融合趋势持续驱动,IDC预计中国边缘计算服务器市场规模将从2022年的40亿美元增长至2026年的92亿美元,系统集成市场需求也将迎来增长。

3、看点:立足AI模型算法研发,产业合作加速算力资源建设

技术创新方面,公司研发费用呈增长态势,自2018年的288万元上升至2022年的1700万元以上,2022年、2023年研发费用分别为1738.51万元、1595.56万元,研发费用率分别为4.41%、3.91%,维持稳定。公司获得北京市“专精特新”中小企业、北京市专精特新“小巨人”企业、国家高新技术企业等称号。公司的研发模式是以自主研发和外包研发的模式进行。截至2023年12月31日,公司正在申请专利14项,目前拥有计算机软件著作权125项。

2023年,蓝耘科技共有研发项目10个,主要围绕AI模型算法开发、AI模型预训练、AI推理等场景的平台和工具的研发。并且开始在平台之上开始构建AIGC等相关应用。为用户从开发、训练到应用部署提供全流程支撑。研发的平台和工具降低了AI技术人员的使用门槛,也降低了应用落地的门槛,提高了应用部署的效率。提升了公司在行业内的竞争力。

蓝耘的GPU智算云服务具体包括三方面:1)GPU虚拟云主机,面向AI训练、图形处理、科学计算等领域,为客户提供专享高性能GPU虚拟云主机,可大幅提升图形处理和计算能力;2)HPC平台,为生命科学、CAE仿真、物理化学、气象环境、石油勘探等领域的科研界提供CPU、GPU算力服务;3)裸金属GPU服务器,提供高性能、资源独享、安全隔离的专属弹性裸金属服务器,同时具备云资源的敏捷性、灵活性和高可用性,蓝耘提供完备的设备管理权限及运维服务。

GPU算力资源整合及优质云平台服务是蓝耘科技在AI时代的核心壁垒。蓝耘GPU算力云服务基于Kubernetes原生云设计,搭载高可配置高可用的英伟达高端GPU系列,支持按需灵活计费、轻松调整存储容量及扩展容量,协同网络架构水平扩展、系统调优及应用排错,可实现现有工作负载轻松迁移、快速部署和弹性拓展,平滑应对突发流量高峰,满足AI训练开发、机器学习、大规模数据处理、分析等计算密集型任务场景中对GPU算力灵活性及多样化的需求,也为集中涌现的AI推理场景应用构筑强大的计算力支撑底座。

大模型便是基于智算算力驱动之下诞生,在云场景下需要GPU算力服务结合高速网络、高性能文件存储应对大规模分布式训练场景,蓝耘科技正广泛开拓该领域客户。得益于模型泛化能力强、长尾数据的低依赖性以及下游模型使用效率的提升,大模型被认为具备了“通用智能”的雏形。

大模型的技术基础是transformer架构、迁移学习和自监督学习,transformer架构应用于NLP、计算机视觉等领域。按“算力当量”(PetaFlops/s-day,PD,即每秒千万亿次的计算机完整运行一天消耗的算力总量)计算,AI+Science领域的AlphaFold2、自动驾驶系统、GPT-3等模型训练需要几百到几千PD算力支持,如GPT-3训练需要3640PD的算力,且GPT-4、GPT-5需求还将指数级上升。

(本文仅供参考,不代表我们的任何投资建议。如需使用相关信息,请参阅报告原文。)