2024AI大模型行业报告:算力需求与技术革新

大模型群雄并起,Kimi打破竞争格局

月之暗面发布Kimi,长文本成为破局关键•月之暗面成为国产大模型新星。

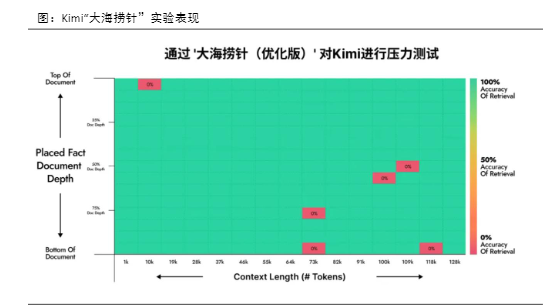

2023年10月,清华大学杨植麟及其AI团队“月之暗面”发布了Kimi,拥有优秀的长文本处理能力,可处理20万汉字输入。同时,利用LongContext可以大幅减少fine-tune的成本,实现模型应用的“多、快、好、省”。例如可以先用5万字定制一个模型的能力,剩余还有大量文字窗口,也足够日常交互使用。而fine-tune需要构造数据并训练,时间较长且需要较高的复杂度,单位token的成本也更高。公司选择用LongContext方式来解决90%的问题,更好向前向后兼容,也成为公司最高优先级的技术突破方向。Ø“大海捞针”测试验证了Kimi长文本能力。长文本能力是实现人类与AI之间无损理解的基础,它使AI可以更准确地理解人类的复杂、感性思维,从而在多种应用场景中更有效地服务于人类。

根据近一年全球各个大模型迭代方向,上下文窗口的“长文本”再持续升级。其中,在文本持续变长过程中,大型是否会忽略掉部分细节内容的问题一直是“长文本”能力的关键。因此有开发者进行了一项名为“大海捞针”的大模型长文本性能测试,即在文本中加入一句与该文本内容不相关的句子,测试大模型是否能通过Prompt把这句话准确提取出来。月之暗面的工程师在2023年12月也进行了测试,选取模型为Kimichat(支持20万汉字输入),GPT-4Turbo(支持128K上下文窗口),Claude2.1(支持200K上下文窗口)。根据测试结果,Kimichat在“大海捞针”中的表现明显好于GPT-4Turbo和Claude2.1.

联合技术及服务壁垒,Kimi有望重塑竞争格局•Kimi通过以下几个核心策略实现了区别于市场的独特定位和快速增长:Ø用户体验中心化:Kimi把用户体验作为产品开发和优化的核心,通过细致了解用户需求,提供流畅、直观的使用体验,提升用户满意度和忠诚度;Ø数据驱动的优化:利用用户行为数据,Kimi采用数据驱动的方法持续迭代产品功能,快速适应市场变化,保持技术和服务的领先优势;Ø创新的分享机制:引入分享功能增强用户互动,同时利用用户生成的数据和反馈优化模型,形成正向的数据循环,提高模型性能和用户体验。Ø专注核心功能优化:专注于提升核心功能如视频高清化等,满足用户特定需求,通过AI技术与用户体验的结合,打造差异化竞争优势。Ø避免过度扩张:Kimi选择专注于现有产品的持续优化,避免过度扩张产品线以确保产品和服务的高质量标准。•国产大模型在算力受限的背景下能表现如此优秀,主要是因为Kimi实现了AI产品发展中三个关键的scaling要素:模型、人才和用户。Ø模型Scaling:Kimi通过持续优化其A1模型,不断增强模型的处理能力和应用范围,成功地提升了产品的核心竞争力。这种模型的scaling不仅涉及到算法的改进和优化,还包括对大数据的处理能力和学习效率的提升,确保模型能够处理更复杂的任务,满足更广泛的用户需求。Ø人才Scaling:注重人才的招聘和培养,扩展人才密度,这对快速推出产品至关重要。Ø用户Scaling:Kimi选择专注于c端市场,致力于开发能够覆盖广大用户需求的通用产品,而不是局限于某个B端的垂直领域。这种策略使Kimi能够吸引到足够大的用户规模,通过规模化的用户反馈进一步优化产品,形成了良好的用户增长和产品改进的正向循环。

Kimi打破竞争格局,带动产业链发展•Kimi优秀的性能可以带动多个产业的发展。Ø阅读和剧本创作中的应用:Kimi的长文本处理能力在阅读和剧本创作领域展现出了深化内容与创新的潜力。它能够为小说和剧本等提供全书总结、剧本评估等高质量服务,这样不仅大幅提升了内容制作的效率,也极大丰富了用户的阅读体验。Ø游戏行业的互动升级:Kimi的长文本能力可用于生成复杂剧情和长篇人机对话极大丰富了游戏的互动性和沉浸感。Ø此外,Kimi的长文本技术突破使得其应用场景从长文章分析扩展至AI陪伴和AIAgent,如扮演小说中的角色或完成专业领域的特定任务。•这一变化为AI在娱乐教育、专业服务等领域的深入应用开辟了新的可能性。Kimi的发展吸引了多方企业的合作,涉及内容审核、数据训练和行业应用等多个环节。这些合作促进了AI技术的实际应用,同时为各合作方带来了增值机会。

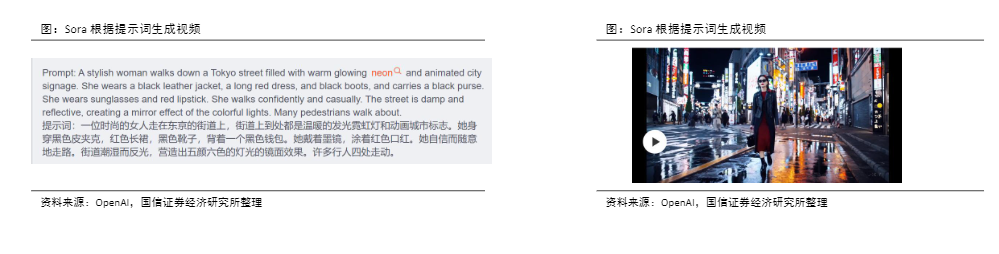

Sora开创AI视频生成新纪元•OpenAI发布Sora大模型,通过Patches和ScalingTransformers革新视频生成技术。Ø多模态融合与Patches技术:OpenAl通过将视觉数据转换为Patches的方法,仿照语言模型中token的应用,实现了文本多模态的统一,涵盖了代码、数学和自然语言等多种形式。Patches作为一种高效且可扩展的表示方法,在生成视频和图像的模型训练中展现了其独特价值。Ø通过时空Patches高效生成视频:OpenAl创新性地开发了一套减少视觉数据维度的网络技术,这项技术可以把原始视频变成一个既在时间上也在空间上被压缩的潜在格式。Sora模型正是在这个压缩后的潜在空间中接受训练,从而能够生成新视频。为了将这些潜在的视频表示重新转化为清晰的图像,OpenAl还专门训练了一个解码器模型。通过对输入视频进行压缩并将其分解为一系列的时空Patches,这些Patches便成了Transformer模型的输入单位。这种方法使得Sora模型能够处理不同分辨率,持续时间和宽高比的视觉内容。在生成视频时,OpenAl能够通过在特定的网格中排列这些随机初始化的Patches,从而有效控制生成视频的大小和形状。这一策略同样适用于图像处理,因为可以将图像看作是静态的单帧视频。ØSora采用ScalingTransformer提升模型效率:OpenAl通过应用ScalingTransformers的技术,成功地扩展了视频生成模型的能力。ScalingTransformers是指一系列旨在提高Transformer模型规模和效率的技术和方法,以便处理更大的数据集、更复杂的任务或在更大规模上运行,同时提高性能。在使用固定的初始条件(种子)和输入数据进行视频样本的训练过程中,OpenAl展示了通过增加训练过程中的计算量(例如,使用更多的计算资源或进行更多次的训练迭代)可以显著提高生成的视频样本的质量。

Sora核心优势:强大的语言理解能力和一致性•Sora核心优势在于强大的语言理解能力和一致性。Ø强大的语言理解:Sora引入了先进的字幕生成技术,借鉴DALL·E3的重字幕(re-captioning)方法,为视频自动生成富有描述性的字幕。这一步骤不仅提升了视频与文字之间的匹配度,还极大改善了视频的整体品质。此外,通过GPT将简短的用户指令prompt转化为详尽的描述,Sora能够精确地按照用户的需求创造视频,显著提高了生成视频的准确度和质量。

以图像和视频作为提示生成视频:Sora的功能不限于将文字提示转换成视频它还能够处理图像或已有视频等多种类型的输入。这种能力让Sora成为一个应用广泛的编辑工具,能够轻松完成包括制作无缝循环视频、将静止图片变为生动动画,以及对视频进行前后时间轴的扩展等多项任务。0penAl通过展示基于DALL·E2和DALL·E3技术生成的示例视频,展现了Sora在图像和视频编辑方面的强大能力和广阔应用前景。Ø灵活的视频扩展技术:Sora使用了基于Transformer架构的扩散模型,可处理多种类型的输入数据,并能够在视频时间线上添加或修改内容。Sora能利用如SDEdit这样的技术,在没有任何预设样本的情况下,改变视频中的风格或背景环境。这意味着用户可以更自由地定制他们的视频内容,不仅限于内容的创建,还包括对视频风格和环境的个性化调整,增强了视频编辑的灵活性和创造性。Ø出色的适应能力:Sora拥有强大的视频生成和调整能力,能够应对不同分辨率和屏幕比例的需求。无论是宽屏格式(1920x1080像素)还是竖屏格式(1080x1920像素),Sora都能够自如地处理,确保生成的视频内容能够完美匹配不同设备的显示需求。此外,在进行高清视频内容创作前,Sora能够迅速制作出低分辨率的视频原型,这一点对于加速创作过程和优化内容设计来说非常有用。简而言之,Sora使得视频制作变得更加灵活和高效,可以根据不同的显示设备和内容需求灵活调整视频规格。Ø场景和物体的一致性和连续性:Sora能制作出视角多变的视频,使得角色和场景的三维移动看起来更自然。它还能有效解决物体被遮挡的问题。传统模型在追踪视野外物体时常常遇到困难,但Sora通过同时预测多帧内容,可以保证即使主体暂时消失在画面中也不会影响其一致性。

OpenAI新一代模型能力有望大幅提升•SamAltman透露新一代大模型相关进展,模型能力大幅提升。2024年1月,OpenAI首席执行官SamAltman先后受邀参加了《UnconfuseMe》、达沃斯经济论坛,透露新一代大模型相关进展:1)大模型进展:目前OpenAI首要任务是推出下一代大模型,可能不命名为GPT-5,展望未来两年,人工智能有望在推理能力和可靠性、多模态(语音输入/输出、图像、视频)、可定制化和个性化三个领域大幅提升,其认为至少在未来5-10年内,AI大模型技术将处于一个非常陡峭的成长曲线上。2)新一代大模型架构和能力提升:OpenAI新一代模型将是一个多模态大模型,支撑语音、图像、代码和视频,并在个性化和定制化方面实现重大更新,具备更强的推理能力和更高的准确性;SamAltman认为如果GPT-4解决了人类任务的10%,则新一代大模型有望解决人类任务的15%或20%;同时,AI大模型的幻觉问题有望在新一代大模型中解决。3)通往AGI之路:大模型能力提升不在于解决具体的问题,而是广泛意义的通用性在逐步增强。

PixVerse定位全球视频多模态应用,引领AI创新潮流•爱诗科技有限公司成立于2023年,是一家迅速崛起的AI视频生成大模型及应用企业。2024年1月,公司推出海外产品Pixverse,具备文生视频、图生视频等多种功能,目前已在海外AI视频生成领域占据一席之地,成为全球用户量最大的国产AI视频生成产品。•To创作者和To消费者的双重策略,目标在2024年底做到大规模的C端应用落地。公司认为AI视频生成产品的第一阶段是To创作者,理解创作者动机;第二阶段将直面消费者。

公司希望打通ToC市场的AI视频生成全链路,持续推进国内外产品迭代,目标在24年底实现大规模C端应用。•访问量快速增长,PixVerse成国产AI视频之光。目前PixVerse已初步搭建了稳定的创作者生态,并根据用户反馈进行模型迭代,在未来有望成为现象级、端到端的AlNative应用。据Similarweb统计,PixVerse在24年2月用户访问量已突破124万次,环比增长120%;2月访问量增速超越海外竞争对手Pika、Runway等,跻身全球AI视频生成工具第一梯队。

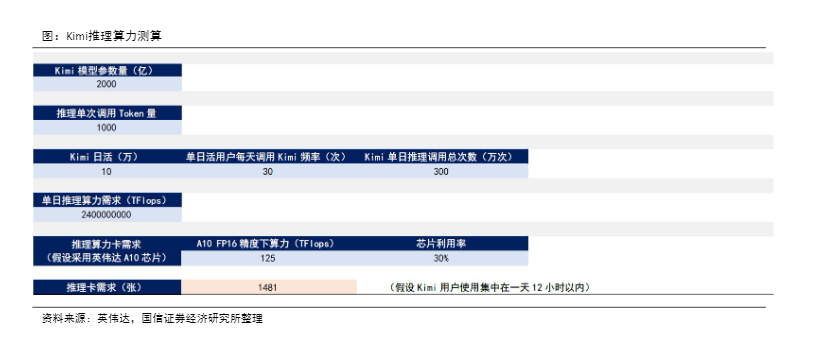

大模型引领全球AI算力需求重估

Kimi火爆拉动算力需求增长•Kimi大模型推理算力测算推理过程:主要包括分词(Tokenize)、嵌入(Embedding)、位置编码(PositionalEncoding)、Transformer层、Softmax。推理主要计算量在Transfomer解码层,对于每个token、每个模型参数,需要进行2x1Flops=2次浮点运算,则单词推理算力消耗为模型参数量x(提问Tokens+回答Tokens)x2。推理算力计算假设及结果:Ø模型参数量:如上文所述,假设Kimi大模型参数量为2000亿。Ø推理单次Token量:正常用户对话通常在1000Token左右,假设推理单次Token量为1000。Ø推理算力需求:根据AI大模型推理算力公式,单次Kimi大模型推理所需算力=2*Kimi大模型参数量*(提问Tokens+回答Tokens)=2*(2000亿)*(1000)=8.0𝐀14Flops=800TFlops。假设Kimi日活为10万,单日活用户每天调用Kimi频率为30次,则Kimi单日推理调用总次数为300万次,则单日推理算力需求为2.4e’TFlops。所需推理卡数及时间:考虑英伟达A10卡目前国内储备量较大、成本较低,假设使用英伟达A10卡进行Kimi模型推理,英伟达A10卡在FP16精度下算力为125TFlops,假设芯片利用率为30%,同时考虑自天高并发因素(即夜间用户并不会使用Kimi),所以假设Kimi推理算力需求会集中在一天12个小时内,则2.4𝐀9TFlops/(125TFLOPsx30%x3600sx12h/天)=1481张A10,即满足10万日活用户推理需求,需要1481张A10算力芯片作为支撑。

Meta算力需求超预期,算力卡采购数量大幅增长•Meta将于24年底拥有接近60万颗H100GPU的等效算力。2024年1月19日,Meta董事长兼CEO扎克伯格在Facebook上发表视频,详细介绍了Meta在人工智能领域的最新进展和未来规划,聚焦于Meta通用人工智能(AGI)的追求,以及Meta做出了相关战略调整。Ø从硬件侧,Meta正在积极部署英伟达H100GPU,计划至24年底部署接近35万颗H100GPU,叠加英伟达A100和其他AI芯片,将拥有接近60万颗H100GPU的等效算力,以支撑下一代AI大模型LIama3的训练;Ø从组织架构侧,Meta将其两大AI研究团队(FAIR和GenAI)合并,共同致力于通用人工智能(AGI)的构建;Ø从智能产品侧,提到了Ray-BanMeta智能眼镜,关注元宇宙未来的发展。图:扎克伯格介绍Meta在AI领域的最新进展和规划资料来源:Meta,国信证券经济研究所整理•24年Meta算力卡采购数量同比大幅增长,算力需求超预期。根据OmdiaResearch统计数据,23年全球大厂纷纷采购H100GPU,其中Meta和微软采购15万颗,位居第一;其次,谷歌、亚马逊、Oracle、腾讯采购5万颗,主要用于AI云业务的建设以及自研AI大模型的训练需要。根据扎克伯格公布的24年算力卡采购预期:ØH100GPU:23年公司采购15万颗,24年预计采购20万颗,同比+33.33%,合计24年底在手35万颗H100GPU,对应增量资本支出12.5亿美金(假设单科H100GPU2.5万美金,增量为5万颗);Ø其他等效H100GPU:24年底等效H100GPU数量达到25万颗,包括A100以及将要出货的英伟达H200、AMDMI300X等AI芯片,由于H100GPU的性价比优于A100,23年全年MetaA100采购数量相对较少,若24年底达到25万颗的等效H100算力,我们认为Meta将大量采购英伟达H200、AMDMI300X等高性价比芯片。

前向传播:输入数据(例如图像、文本等)通过神经网络的各层进行传递,以得到输出结果,包含输入数据与权重矩阵相乘、应用激活函数等操作,目的为将计算网络预测输出,并将其与实际目标值比较,计算损失函数(LossFunction)的值。Ø反向传播:一种高效计算梯度算法,从输出层开始,沿着网络层次结构向输入层反向传播,计算每个权重的梯度(注:梯度表示权重对损失函数贡献的大小);同时,在计算出所有权重的梯度后,使用优化算法更新权重,达到减小损失函数值的目的。Ø计算次数:一次前向传播需要一次计算,一次反向传播需要两次计算(计算梯度+权重更新),则完成一次神经网络迭代需要对所有输入的数据和模型参数进行3次计算;每一次计算就是矩阵运算,对于一次矩阵运算需要进行一次乘法及加法(共计2次浮点运算),即对于每个Token、每个模型参数,需要进行2×3Flops=6次浮点运算。以GPT-3大模型训练为例,模型参数量为175B,训练Token数量为300B,采用稠密(Dense)模型,其需要的训练总算力为175B×300B×6=3.15𝐀23FLOPs。Ø所需算力卡数量及时间:假设使用业内FLOPS最大的利用率来测算(此处取46.2%),单卡A100FP16精度下算力为312TFLOPS,则3.15𝐀23FLOPs/(312TFLOPs×46.2%×3600s×24h/天)=2.53万张A100/天,即若使用1000张A100,大约训练一遍GPT-3需要25.3天。表:芯片利用率情况资料来源:AakankshaChowdhery等著-《PaLM:ScalingLanguageModelingwithPathways》-arXiv(2022)-P9,国信证券经济研究所整理Model#ofParameters(inbillions)AcceleratorChipsModelFLOPSUtilizationGPT-3175BV10021.3%Gopher280B4096TPUv332.5%Megatron-TuringNLG530B2240A10030.2%PaLM540B6144TPUv446.2%•大模型推理算力测算:推理过程主要包括分词(Tokenize)、嵌入(Embedding)、位置编码(PositionalEncoding)、Transformer层、Softmax。推理主要计算量在Transfomer解码层,对于每个token、每个模型参数,需要进行2×1Flops=2次浮点运算,则单词推理算力消耗为模型参数量×(提问Tokens+回答Tokens)×2。

(本文仅供参考,不代表我们的任何投资建议。如需使用相关信息,请参阅报告原文。)