2024年中小盘行业周报:新能源汽车与智能驾驶技术进展

一、政策支持,投资启动,国内智算中心加速建设

智算中心:新质生产力的引擎,主权AI的基础

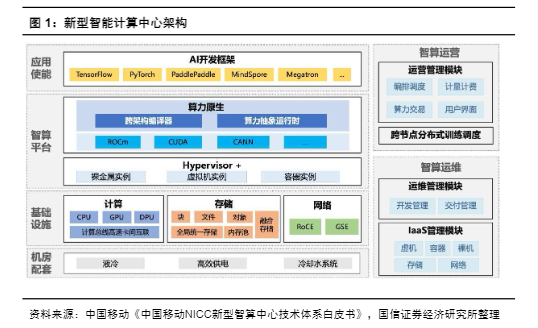

智算中心是以GPU、AI 加速卡等智能算力为核心、集约化建设的新型数据中心,为人工智能应用提供所需的算力服务、数据服务和算法服务,使能各行各业数智化转型升级。作为AI 技术发展的关键底座,智算中心的建设和部署在全球范围内提速。从国内视角,一方面,AI是新质生产力的构成,而算力中心是AI发展的基础和引擎,另一方面,黄仁勋也提出主权AI的概念——每个国家都需要拥有自己的人工智能基础设施。◆全球算力竞争加速,我国智算算力储备对比美国相对落后。据工信部数据,2023年我国智算算力达到70EFlops,同比增长70%;海外高性能算力芯片出货快速增长,推动算力规模爆发,推算2023年英伟达H100新增算力有望超过1000EFlops(FP16)。◆基于此,政策上我国高度重视AI发展,而在落地方面,国内互联网龙头、ICT龙头、运营商等先后推出大模型产品,如Kimi等产品用户量增长迅速。我国智算中心建设正加速布局,并且国产算力自主可控的产业趋势明确。

国内智算能力有望加速追赶海外——网络角度

随着AI集群的规模不断扩大,智算能力的落地不仅以来单卡性能的提升,超大规模集群的系统和工程能力也发挥重要作用。网络层面,当前的AI集群规模已经从数千个GPU增长到数万个GPU,未来可能会发展到数十万乃至数百万个加速单元的超级计算集群,AI时代需要建造比现在规模更大的数据中心,或者将一个数据中心内部分割出多个集群建筑单元,构建一个逻辑上规模更大的数据中心。更大规模的AI集群需要DCI互联网络支撑。◆我国在分布式智算中心所需的DCI网络层面有望发挥优势。如中国移动已开启骨干网400G升级;中国电信联合华为2024年2月份在北京电信现网完成800G超高速波分技术验证,于近日成功在实验室完成万亿/十万亿级参数大模型分布式训练仿真验证,在北京电信武清、永丰、瀛海三地IDC机房完成数百亿参数经典大模型的分布式训练任务,测试分布式训练性能达到集中式单智算中心训练性能的90%以上。其中在瀛海到武清的业务节点,进一步验证了单波PS-64QAM 1.2T的现网传输能力。

“东数西算”工程有望发挥西部区域能源优势,匹配AI增长电力供给压力。国际能源署(IEA)预测,全球数据中心的用电量可能从2022年的460太瓦时(TWh)飙升至2026年的1050太瓦时(1太瓦时相当于10亿千瓦时),在4年内翻一番,电力将成为制约算力发展的关键因素。东数西算等战略工程下,我国西部区域能源优势有望匹配算力增长。

总体规划层面,政策注重人工智能发展,对底层基础设施,尤其是智算中心加强规划。如国务院国资委召开中央企业人工智能专题推进会。会议认为,加快推动人工智能发展,是国资央企发挥功能使命,抢抓战略机遇,培育新质生产力,推进高质量发展的必然要求。其中提出要夯实发展基础底座,把主要资源集中投入到最需要、最有优势的领域,加快建设一批智能算力中心。◆地方政府层面,上海、北京等多个地方政府已先后出台政策,在算力、运力、存储方面均有明确规划。

运营商2024年资本开支精准投放,加强算力领域投资:➢中国移动规划2024年投资1730亿元,其中,算力规划投资475亿元(同比+21.5%)。中国移动已形成10.1 EFLOPS智算算力(FP16),规划2024年底实现智算算力>17 EFLOPS(同比提升约7 EFLOPS)。➢中国电信规划2024年实现资本开支960亿元(同比-3%),其中产业数字化资本开支369.6亿元(占38.5%,提升2.5pct),包括面向云/算力领域投资180亿元。中国电信已具备11 EFLOPS智算算力,2024年计划新增>10EFLOPS 智算算力。➢中国联通规划2024年资本开支650亿元(预计同比-12%),投资重点由稳基础的联网通信业务转向高增长的算网数智业务。

三大运营商已先后开启AI服务器招标:➢中国移动近期启动2024年至2025年新型智算中心的大规模采购,规划采购7994台AI训练服务器及60台以太网交换机;此前,移动2023-2024年新型智算中心(试验网)集采项目12个标包对应AI训练服务器采购量总计达到2454台(1-11标包集采1204台,12标包集采1250台)。➢中国电信2023-2024年AI服务器共采购4175台训练型服务器,其中G系列(鲲鹏CPU)训练服务器合计招标1977台(合计金额约27.8亿元),I系列(Intel CPU)训练服务器合计招标2198台。➢中国联通2024年3月23日首次集采AI服务器,根据预审公告,中国联通本次将采购2503台AI服务器,688台关键组网设备RoCE交换机。

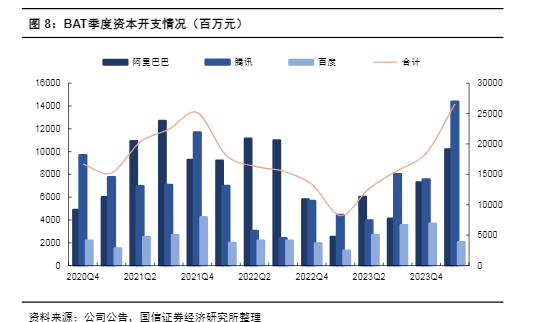

国内互联网厂商资本开支显著回暖,AI为重要投资方向。2023年三季度开始,国内BAT合计资本开支实现同比增长,趋势在2024年一季度延续——据BAT财报显示,24Q1合计资本开支265.7亿元,同比增长223%,环比增长44%。其中,阿里巴巴资本开支101.7亿元(同比+305%,环比+40%),腾讯资本开支143.6亿元(同比+226%,环比+91%),百度资本开支20.4亿元(同比+57%,环比-44%)。AI是BAT重要的投资方向,百度、阿里、腾讯等公司密集发布大模型,BAT 也均表示将持续加大人工智能投入。

美国对中国先进芯片进口限制持续升级。2022 年8月,美国首次针对中国实施大规模芯片出口制裁,停止出口A100和H100两款芯片和相应产品组成的系统。2023 年10 月,美国颁布新的半导体出口限制,对芯片算力和性能密度做了更严格的规定,对性能满足以下条件的芯片实施出口管制:(1)总计算能力TPP(算力*位宽)超过4800的芯片;(2)TPP超过1600且PD(TPP/芯片面积)超过5.92的芯片;(3)2400≤TPP<4800,且1.6≤PD<5.92的芯片;(4) 1600≤TPP,且3.2≤PD<5.92的芯片。根据该要求下,英伟达A100/A800、H100/H200/H800、L4、L40s均不满足出口条件。2024年4月美国再次修订防止中国取得美国AI芯片和芯片制造设备的规定。这一背景下,国内算力自主可控是必然趋势。

以鹏城云脑II为例,我们重点关注国产智算中心的基础设施——服务器、温控、交换机以及光模块:➢(1)AI服务器配置:采用Atlas 800 AI服务器,基于2个鲲鹏920 CPU和8个昇腾910A AI加速器。单机柜8台AI服务器,合计计算机柜数量64个,总计4096张昇腾910A AI加速器。➢(2)交换机:采用RoCE v2网络。通用算力和AI算力面采用华为FM8850-64CQ-E1交换机,64*100G接口配置;样本面和业务面采用华为FM6865-46 S8CQ-E1交换机,48*25G接口配置;设备管理面采用GES5735交换机。➢(3)光模块:昇腾910和鲲鹏920直出接口速率为100G。➢(4)散热:采用液冷散热,PUE小于等于1.25。

万卡以上的大规模集群加速建设。以运营商为例,中国移动预计24年商用三大自主可控万卡集群——即哈尔滨、呼和浩特、贵阳三个自主可控万卡集群,总规模近6万张GPU,充分满足大模型集中训练需求;同时推理方面,中国移动将按需在1500个边缘节点部署推理算力,形成“中心大集群、边缘广分布、中训边推、训推一体”的智算网络。中国电信3月22日宣布天翼云上海临港国产万卡算力池正式启用,算力集群规模达15000卡,其中包括全国首个单池万卡规模的国产液冷算力集群。

我国国产AI芯片以华为昇腾系列为代表,蓄势待发。华为于2018年首发昇腾310推理芯片,可用于边缘计算领域;2019年发布昇腾910训练芯片应用于云端领域;2023年科大讯飞公布其使用华为昇腾910B的星火一体机,据科大讯飞,其性能可对标A100。另据路透社报道,百度为200台服务器订购了1600片昇腾910B。华为之外,海光信息深算三号、寒武纪思元590等国内芯片厂商以及互联网大厂自研芯片布局也在持续推进。

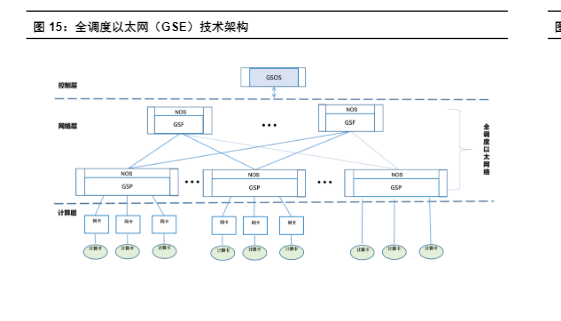

AI组网采用以太网具有性价比优势,全球及国内均提出以太网优化协议。以太网在AI集群中主要采用RoCEv2协议,但对比IB网络,以太网本身仍然在丢包等方面存在一定性能差距。全球范围来看,超以太网联盟(UEC)组建,旨在打造高性能以太网,以新形式进行传输层处理,在非无损网络的情况下也可实现以太网性能提升,较RDMA更灵活;国内中国移动牵头“全调度以太网(GSE)推进计划”,基于逐包的以太网转发和全局调度机制,突破传统无损以太性能瓶颈,中国移动计划于2024年开展GSE中试,近期已发布《新型智算中心以太网物理层安全(PHYSec)架构白皮书》。

网络带宽是训练算力的瓶颈之一,点对点通信速率加速升级。大模型训练产生庞大的集群内通信流量,GPT 3.5的训练仅是单次计算迭代内梯度同步需要的通信量就达到了百GB 量级,此外还有各种并行模式、加速框架引入的通信需求。一个高效的模型在硬件依赖三个环节的性能改进——存储、计算和通信能力,在存储和算力一定的情况下,AI模型训练的效率将取决于通信时长。而存储和算力分别可通过HBM应用、GPU算力提升等方式解决,通信时长则由数据量和通信带宽决定,因此提高通信带宽有助于提升训练集群的计算效率。

单服务器、单机柜功率持续提升,PUE考核下AIDC加速液冷应用。随着单卡功率的持续提升,AIDC集群的单机柜功率显著提升。如H100单卡TDP 700W,对应单服务器设计功率约10kW,以标准单机柜4个AI服务器计算,单机柜功率超过40kW。同时AIDC电力紧缺已成为初步共识,采用液冷降低PUE有望节约整体数据中心电能消耗。国内双碳目标下推动PUE考核趋严,加速带动液冷渗透率提升。

二、服务器:算力服务器快速增长,液冷、机架式方案应用加速

通算需求相对疲软,整体出货量下降

通算服务器需求相对疲软,算力服务器快速增长。服务器整体市场维度,2023年由于宏观经济不景气、库存周期以及资本开支等因素影响,服务器市场出货量下海,据IDC数据显示,2023年全球服务器出货量约371万台,同比下降6%;受益于AI服务器出货增长,由于价值量较高,总体服务器市场规模同比提升11.8%至306亿美元。

AI服务器需求高增。Trendforce预计2023年AI服务器(包含搭载GPU、FPGA、ASIC等)出货量近120万台,同比增长38.4%,占整体服务器出货量近9%,至2026年将占15%,2022-2026年AI服务器出货量年复合成长率至22%。◆国内视角,IDC数据显示2023年上半年加速服务器市场规模达到31亿美元,同比增长54%,预计2027年中国加速服务器市场规模将达到164亿美元。

国内AI服务器竞争格局:浪潮信息份额靠前,关注昇腾系厂商

AI服务器视角,此前浪潮信息份额靠前。据IDC数据,2022年国内加速计算服务器市场中,浪潮信息、新华三、宁畅位居前三,份额分别为47%、11%、9%,浪潮信息份额大幅领先。◆随着国产芯片发展,国内AI服务器竞争格局或产生变化(参考运营商招标),昇腾系相关服务器厂商份额有望提升。

服务器趋势一:卡间高速互联规模扩大,机柜式方案有望加速应用

基于Transformer 的大模型演进趋势遵循Scaling Law,参数量走向万亿级是可预见的必然趋势。新型的算法结构带来了新的分布式训练策略,如专家系统(Mixture-Of-Experts,MoE)并行,高速通信需求进一步扩展至百卡级别,卡间互联的最优解指向Switch 交换拓扑,“超级服务器”等机柜式方案有望加速应用——通过利用提高GPU 南向的Scale up 互联能力,提升张量并行或MOE 并行对大模型训练任务的收益,实现性能跃升,缩短训练总时长,实现大模型训练整体性能的优化。

海外芯片厂商中,英伟达已先后推出GH200、GB200等机架式方案,扩大卡间互联规模。英伟达通过私有协议NVLink实现卡间互联,在此前GH200方案中,英伟达采用2层fat-tree网络结构实现256张GH200超级芯片互联;GB200架构中,英伟达推出NVL72方案,单机柜集成72个全互联的Blackwell芯片,英伟达也推出双机柜(NVL36)方案,也可通过2层NVLink交换实现最大576个GPU的全互联。

国内芯片厂商也推出相应卡间互联协议。如华为的HCCS(high-speed cache coherence network)、寒武纪的MLU-LINK、燧原的GCU-LARE和壁仞的B-LINK等。对比NVLink已经采用Switch 交换或全互联的拓扑结构达到8 卡或百卡级别的互联,国内厂商技术方案大多采用cube 类拓扑实现8卡成环连接,相比之下在集群总吞吐和规模能力上均有代际差。但产业趋势明确,基于国内卡间互联协议的机架式方案有望加速应用。

对比光互连,铜互联拥有功耗、成本等方面的优势。英伟达GB200 NVL72方案中,72个GPU通过超5000根铜缆实现互联,在短距离连接中,铜互联对比光互连具有成本低、功耗低等优势——正如英伟达官网对以太网DAC铜缆产品的优势描述包括:成本最低的高速互联、功耗和延迟接近零、高度可靠。

数据中心短距离通信所需的高速铜缆持续优化。以直连铜缆为例,直连铜缆(Direct Attach Cable,DAC)是两端带有固定接头的线缆组件。作为高速传输线缆,DAC采用平行对称结构,大幅提升传输带宽和传输速率,同时降低了对内对间的时延差,提高了抗电磁干扰能力,其单通道传输速率最高已可达到224Gbps。◆DAC又分无源DAC (Passive Copper Cable)和有源DAC(Active Copper Cable),后者通过加入芯片增加传输距离。无源DAC使用屏蔽的高速差分铜缆,两端的电路板上没有芯片,整个信号传输过程中,未对信号做任何处理。有源DAC内部具备预加重、均衡等高速电信号补偿芯片,对电信号传输过程中的衰减进行补偿,可以增加数据传输距离。为了进一步增加传输距离,业界演进出AEC(Active Electrical Cable),在线缆两端加入CDR。

铜互联:关注高速背板连接器

参考GB200机架式方案:(1)计算单元(Compute Tray)通过背板连接器连接到背板,并通过铜缆连接到NVLink交换机,实现GPU和交换机的互联;(2)交换机内部,交换芯片通过4个跳线连接器与背板连接器连接。◆考虑到NVLink协议速率较高(NVLink4.0双向1800GB/s),如前文所述,出于带宽考虑,对比NVLink已经采用Switch 交换的拓扑结构达到8卡或72卡的互联,国内厂商技术方案大多采用cube 类拓扑实现8卡成环连接,短期内国内机架式方案或仍不会引入Switch组成芯片拓扑架构。国内机架式方案或采用类似叶脊架构(多轨)的组网方案,但高速背板仍有望应用。

(本文仅供参考,不代表我们的任何投资建议。如需使用相关信息,请参阅报告原文。)