2024年数据中心液冷技术发展与市场前景报告

1数据中心“算力热”与“散热焦虑”,头部厂商引领液冷渗透率快速提升

1.1GPU算力爆发增长下全球数据中心能耗快速提升

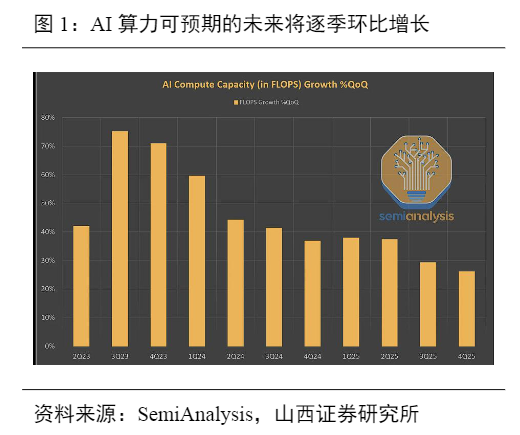

全球AI算力快速增长,且芯片TDP功率持续提升,为数据中心制冷带来挑战。根据SemiAnalysis数据,2023Q3-Q4AI算力环比增速保持在70%以上,预计从2024Q1开始,AI算力每季度环比增速还将维持在30%-60%。除全球AI算力高增,各大芯片厂商的TDP功率也在飞速提升,根据S&PGlobal数据,2017年主流芯片厂商TDP仅为200w左右,到2023年,一般GPU的TDP已经达到350-700W,NVIDIA新一代B100功耗甚至超过1000W。

AI服务器出货量将迎来高增,AI数据中心将成为数据中心能耗爆发的主要推手。根据TrendForce,2023年全球AI服务器(包含搭载GPU、FPGA、ASIC等)出货量将接近120万台,同比+38.4%,占整体服务器出货量的比重约9%,预计2024年占比将达到12.1%,对应出货量165万台,同比+37.7%。AI服务器出货量激增带来数据中心能耗爆发,根据SemiAnalysis数据,2023-2026年,全球数据中心能耗将从49GW增至96GW,3年CAGR超25%,其中AI算力能耗将迎来结构性激增,到2026年将超40GW,占数据中心总能耗超40%。GenAI推动数据中心快速扩容,根据S&PGlobal假设,保守情况下,如果AI数据中心采用H100或以上的GPU,对应芯片功耗400-700W,利用率为60%,则为了支持GPU的增量,2028年需额外增加的数据中心容量将超21GW;根据2023年初确认的数据中心增量,若假设其中已有20%是GPU负载,则2028年GPU芯片带来的数据中心净新增容量也将接近17GW。

1.2液冷具有综合OPEX优势,或加速在数据中心渗透

芯片TDP和机柜容量持续提升,传统风冷需要向液冷过渡。根据S&PGlobal数据,当TDP达200-300W时,散热系统需要特殊的气流管理、更大的散热片以及更高的风扇体积和转速;当TDP达350-400W时,风冷服务器散热逐渐接近极限,导热系数更高的液冷将成为必然选择。NVIDIA新一代B100功耗可能超过1000W,意味AI算力所需机柜功率更高,根据《2021-2022年度中国数据中心基础设施产品市场总报告》和立鼎产业研究网数据,我国约90%以上的机柜功率密度在15kW以下,但未来主流机柜功率预计会25kW-50kW/柜,甚至更高。而液冷技术以其低PUE(冷板式液冷PUE<1.2、浸没式液冷技术PUE<1.1,节能20%-30%以上)、满足高密度部署(降低占地和建设成本)、服务器运行更加安全可靠(CPU温度低至65°C以下)、全年全地域适用等优势,有望解决能耗和散热发展瓶颈。

驱动液冷规模应用关键是TCO(全生命周期成本),当下冷板式液冷综合OPEX已经较风冷具备优势。根据Supermicro数据,以H100为例,冷板液冷建设费用较风冷方案高约3万美元;由于不需要风扇,液冷条件下GPU服务器功耗将从7kW降低至6.3kW,则液冷、风冷单机柜芯片功耗分别为50.4kW和56kW,而液冷PUE可由风冷状态下的1.5将至1.1,对应液冷、风冷单机柜总功耗分别为55.44kW和84kW;假设电价为0.12美元/kW,则数据中心运营3年后,液冷方案将节省超6万美元。

政府对PUE的监管要求不断提高,我国仍有较大下降空间。《新型数据中心发展三年行动计划(2021-2023年)》提出,到2023年底,新建大型及以上数据中心PUE降低到1.3以下,严寒寒冷地区力争降低到1.25以内。2022年“东数西算”一体化大数据中心建设,明确要求集群内的数据中心PUE在东部地区要低于1.25,在西部地区要低于1.2,先进示范工程降低到1.15。

目前我国大部分数据中心能耗较高,根据华为《2024年数据中心能源十大趋势白皮书》,截至2022年底,全国数据中心650万架存量中,PUE>1.5的占比超50%,仍有较大下降空间。液冷是降低PUE的有效方式。根据《绿色节能液冷数据中心白皮书》及赛迪顾问,2019年中国数据中心制冷耗电占比约43%,位居第二,仅次于IT设备自身能耗占比(约为45%);而液冷可以取代大部分空调系统(压缩机)、风扇等高能耗设备,实现节能20%-30%以上,以某液冷数据中心为例,液冷设备取代空调设备,耗能占比仅为9%。根据《绿色数据中心白皮书2019》,采用传统风冷的数据中心PUE平均在1.6左右,而冷板式液冷和浸没式液冷分别能将PUE降低到1.3、1.2以下。

液冷是数据中心基础设施投资重要组成部分,拉动数据中心热管理市场高速增长。根据SemiAnalysis数据,从2023年到2026年,全球数据中心资本支出(不包括服务器和网络等IT设备)将从490亿美元增长至1670亿美元,3年CAGR达50.5%,其中,电力系统投资占比40-45%,对应2026年市场规模670-750亿美元,包括变压器、中压开关设备、发电机、不间断电源(UPS)、开关设备和配电;热管理系统投资占比30%,对应2026年市场规模500亿美元,包括机房空调机组、机房空气处理器、冷水机组和冷却塔、冷却剂分配装置(CDU)等。

数据中心基础设施领域中,热管理市场具备快速增长的潜力。据Dell'OroGroup2024年2月的预期测算数据,预计2028年数据中心热管理市场规模(风冷+液冷)将达120亿美元,其中液冷规模将达35亿美元,占热管理总计支出的近1/3,对比目前占比仅不到1/10,具备广阔的市场空间。

1.3英伟达、华为、运营商等引领液冷产业快速发展

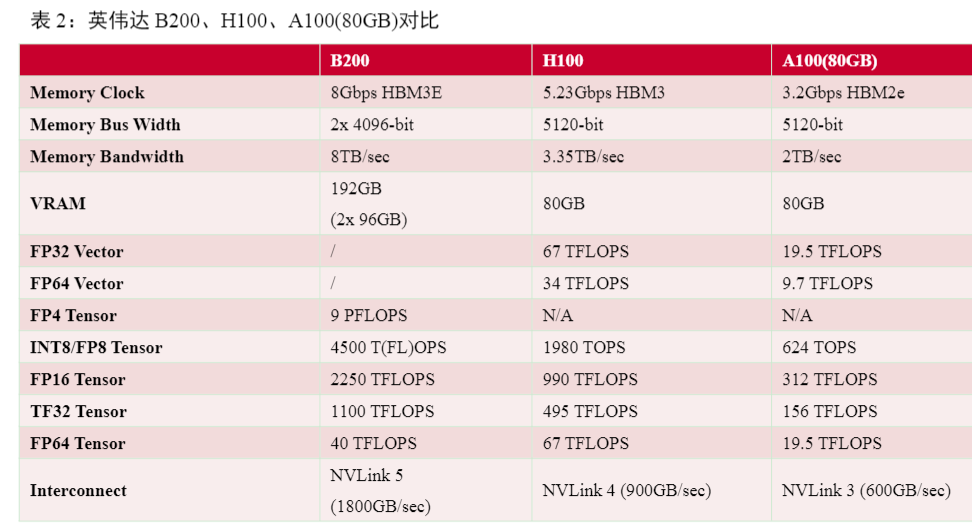

英伟达开启液冷AI算力时代。2024年3月19日,英伟达在GTC大会发布了Blackwell架构的B200芯片,它由两个紧密耦合的芯片组成,通过10TB/sNV-HBI连接,包含2080亿晶体管,配备192GBHBM3E,存储带宽8TB/s,在液冷配置下,芯片在满负荷运作时的热输出可以达到1200W,AI算力可达20petaFLOPS(FP4);GB200超级芯片由2个B200GPU与GraceCPU通过900GB/s的超低功耗NVLink芯片间互连组成,在标准的1750亿参数GPT-3基准测试中,GB200的性能是H100的7倍,提供的训练算力是H100的4倍,总功耗可能达2700W;DGXB200配备8个与第五代NVLink互连的BlackwellGPU,训练性能是前几代产品的3倍,推理性能是前几代产品的15倍,可以处理各种工作负载,包括大型语言模型、推荐系统和聊天机器人;“新一代计算单元”GB200NVL72采用了液冷机架级解决方案,使成本和能耗降低25倍,以机架级设计连接36个GraceCPU和72个BlackwellGPU,拥有72个GPUNVLink域,可充当单个大型GPU,实时万亿参数LLM推理速度提高30倍。

华为昇腾910系列液冷版本性能提升明显,已实现AI计算中心全栈液冷交付。华为第四届全联接大会上发布了Atlas900超级计算机,由数千颗昇腾910AI处理器构成,总算力达到256P~1024PFLOPS@FP16,采用了混合液冷方案,实现了超过95%的液冷占比,并具备极致的数据中心能源效率,大幅度降低能耗和碳排放。根据华为公布的atlas800训练服务器风冷和液冷配置对比,液冷版本AI算力下限较风冷版本提升100%。此外,华为已实现了AI计算中心全栈式液冷预制模块化交付,单柜支持43KW,用电节省60%,AI集群PUE<1.15。

电信运营商高度重视液冷技术,有望积极推动液冷技术发展。《电信运营商液冷技术白皮书》指出了电信运营商在液冷方面的三年愿景,2023年,以技术验证为主,储备规划、建设与维护等技术能力;2024年,开展规模测试,推进新建项目10%试点液冷技术;2025年,保证50%以上项目规模应用,推进形成标准统一、生态完善、成本最优、规模应用的高质量发展格局。

2解读液冷产业链环节,冷板式液冷有望率先渗透

2.1液冷具有冷板式、浸没式、喷淋式三种技术路线,冷板式当前最具性价比

液冷方式各有优劣,目前主流应用方式为冷板式液冷和单相浸没式液冷,我们认为冷板式液冷将成为未来主流路线。冷板式液冷需要定制,成本较高,但在可维护性、空间利用性、兼容性等方面较为优秀,由于国内冷板式液冷起步较早,具有先发优势,因此实际应用场景广泛。浸没式液冷虽然可维护性和兼容性较差,且设施需要重新安装,但在空间利用率、可循环方面表现良好,其中,两相浸没式液冷过程中冷却液会发生相变,控制相对复杂,且冷却液易受污染;单相浸没式液冷相较于两相浸没式液冷,冷却液沸点较高,能够相对简单地控制冷却液挥发流失,与IT设备元器件兼容性更强,无需频繁补充冷却液,因此单相浸没式相比双向浸没式应用更为广泛。喷淋式液冷需要保证冷却液按需分配,运行维护复杂,维护时易破坏服务器原有密封结构,应用生态较为局限,因此实际应用的范围有限,目前国内代表性厂家包括广东合一等。

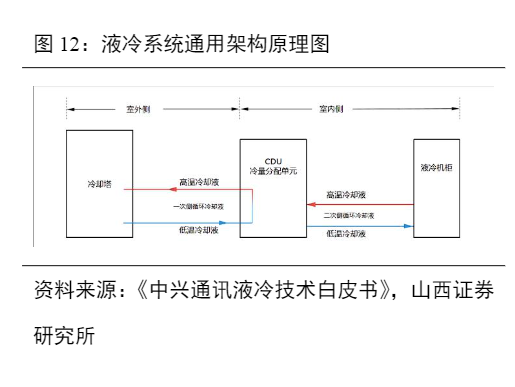

冷板式液冷是将换热器直接贴合发热部件放置散热的技术,采用微通道强化换热手段,具有极高的散热性能,目前行业成熟度最高。冷板式液冷系统主要由冷却塔、CDU、一次侧&二次侧液冷管路、冷却介质、液冷机柜组成;其中液冷机柜内包含液冷板、设备内液冷管路、流体连接器、分液器等。作为非接触式液冷,冷却液并不直接接触发热设备,而是通过接触冷板运输热量,一般不需要改变数据中心机柜结构。冷板式液冷在行业内有10年以上的技术积累,目前在三种主流液冷方案中技术成熟度最高。浸没式液冷是将发热设备完全浸没在冷却液体里实现散热的技术,可实现更低功耗。浸没式液冷设备结构较为简单,省去了压缩机等制冷部件,仅保留冷却液和循环泵,室外侧包含冷却塔、一次侧管网、一次侧冷却液;室内侧包含CDU、浸没腔体、IT设备、二次侧管网和二次侧冷却液。

使用过程中IT设备完全浸没在二次侧冷却液中,因此二次侧循环冷却液需采用矿物油、硅油、氟化液等不导电液体。该液冷技术采用发热设备与冷却液体充分接触的方式,接触面大,换热效率高,需求的液体流速低,循环泵的功耗低,因此能够实现较低的功耗。以冷却液是否在循环散热过程中发生相变,又分为单相和两相浸没式液冷。喷淋式液冷是将冷却液直接喷洒于发热器件实现控温的技术,节能效果弱于浸没式液冷,是三种路径中运行维护最复杂的系统。相较于浸没式液冷,喷淋式液冷系统更为复杂,主要由冷却塔、CDU、一次侧&二次侧液冷管路、冷却介质和喷淋式液冷机柜组成;其中喷淋式液冷机柜通常包含管路系统、布液系统、喷淋模块、回液系统等。

相较于其他液冷方式,冷板液冷具有部署&运维简单、CAPEX低、产业链成熟等优势,我们认为冷板式将是液冷发展的重要方向。(1)部署运维环节:液冷会对传统数据中心尺寸、形态、重量、运维方面都提出新要求,相较于浸没式液冷,冷板式液冷对改造、部署要求较低,可行性更强。根据《冷板级液冷服务器设计白皮书》,冷板式液冷机房设备重量较浸没式可降低68%-75%;体积方面可维持传统机房尺寸不变;且不需要独立运维空间。(2)TCO环节:对于CAPEX(包括机电、土建、外电、能评)方面,由于板冷比风冷的散热效率更高,在特定功率密度下板冷的CAPEX已经初具优势,根据CDCC假设,对于30kW机柜的CAPEX,风冷、板冷、单相浸没每ITkW的平均成本分别为2.6、2.1、3.1万元;对于OPEX(包括电费、水费)方面,由于风冷用电量最高,运营成本较高,风冷、板冷、单相浸没每ITkW/月的平均成本分别为795、685、665元。综合来看,风冷、板冷、单相浸没每ITkW/月的TCO成本平均分别为1229、1057、1204元,板冷在TCO成本具备明显优势。

我们预计,到2028年,冷板、浸没式液冷数据中心市场空间有望达900亿元。我们预计2028年全球服务器CPU出货量将超3600万片,对应单芯片服务器平均功耗约290w,冷板、浸没式液冷渗透率分别将增长至25%、6%;全球服务器GPU出货量将接近1500万片,对应单芯片服务器平均功耗约1800w,冷板、浸没式液冷渗透率分别将增长至55%、6%;冷板、浸没式液冷单kW投资额分别下降至3400、9600元左右,则2028年CPU服务器冷板、浸没式液冷市场空间分别约135、95亿元,AI服务器冷板、浸没式液冷市场空间分别超500、160亿元。

市场格局方面,当前国内企业已经初步积累了一定的技术优势和先发优势,未来有望在全球范围内继续扩大份额。对于海外企业,冷板式液冷市场主要参与者包括CoolITSystems(美国)、Asetek(丹麦)、Motivair(美国)等;浸没式液冷市场主要参与者包括GRC(美国)、LiquidStack(美国)、Midas(美国)等。谷歌、微软、英特尔、IBM、HP等公司也已经在液冷技术领域有所布局。国内市场中,部分企业已具备成为龙头厂商的潜力。据信通院《中国液冷数据中心发展白皮书》对于中国液冷数据中心厂商竞争力的研究,基于产品营收、市占率、客户反馈等指标,中科曙光、浪潮信息为市场的领导者,华为、阿里巴巴、联想、英维克、高澜股份、维谛技术、广东合一、宁畅等紧随其后。

2.2冷板式液冷产业链环节

冷板式液冷系统包括一次侧(室外)和二次侧(室内)两部分,一次侧指将二次侧的热量排至室外环境或其他热回收单元的环路;二次侧指从服务器带走热量并在一次侧进行散热的环路,两个部分通过CDU(冷量分配单元)中的板式换热器发生间壁式换热,工质不做混合。核心部件包括一次侧的冷却塔(用于热交换),二次侧的液冷板(位于服务器内部)、工质回液歧管manifold(位于机柜上)、快速接头(用于连接服务器),以及用于连接一次侧和二次侧的关键部件CDU。

液冷板是一种高效的散热设备,它通过在板表面构建细小的水道和冷却通道,利用流体流经这些通道时,有效地将热量传递到水中,并通过水的流动带走热量,从而达到散热的目的。液冷板通常由热导率高且耐腐蚀的铜或铝制成,具有多个薄片状通道,这些通道内填充着液态介质。

设计方面,冷板可以根据不同的需求进行结构设计优化,主要的内部流道形式包括沟槽、扣合翅片、铲齿、折叠翅片以及更复杂的微通道结构。材料及工艺方面,液冷板制作需要埋管工艺,通常包括浅埋管、深埋管、焊管、双面夹管工艺,一般情况是铝基板埋铜管,即将铝基板用CNC加工铣槽,再采用冲压机将已弯好形状的铜管压到铝基板上,再进行钎焊焊接。主要供应商包括英维克、高澜股份、曙光数创、飞荣达、英特科技、银轮股份等。CDU负责将冷却剂或水均匀地分配到整个系统中。冷却工质在CDU循环泵的驱动下进入冷板,在液冷板内通过强化对流换热吸收热量温度升高,高温工质通过CDU换热器将热量传递到一次侧冷却液,实现降温过程。CDU可以调节及控制冷却剂的流量,以维持系统所需的温度和流速,还包括感应、监视、流量控制和去除杂志等功能。国外供应商包括nVentSchroff、Emerson、Boyd、Vertiv、DCX、Nidec、Rittal、Asetek等,国内供应商包括英维克、高澜股份、蓝洋科技、台达、同飞股份等。

(本文仅供参考,不代表我们的任何投资建议。如需使用相关信息,请参阅报告原文。)