2023生成式人工智能服务合规发展白皮书

今天分享的是生成式人工智能系列深度研究报告:《2023生成式人工智能服务合规发展白皮书》。(报告出品方:(中伦)

报告共计:84页

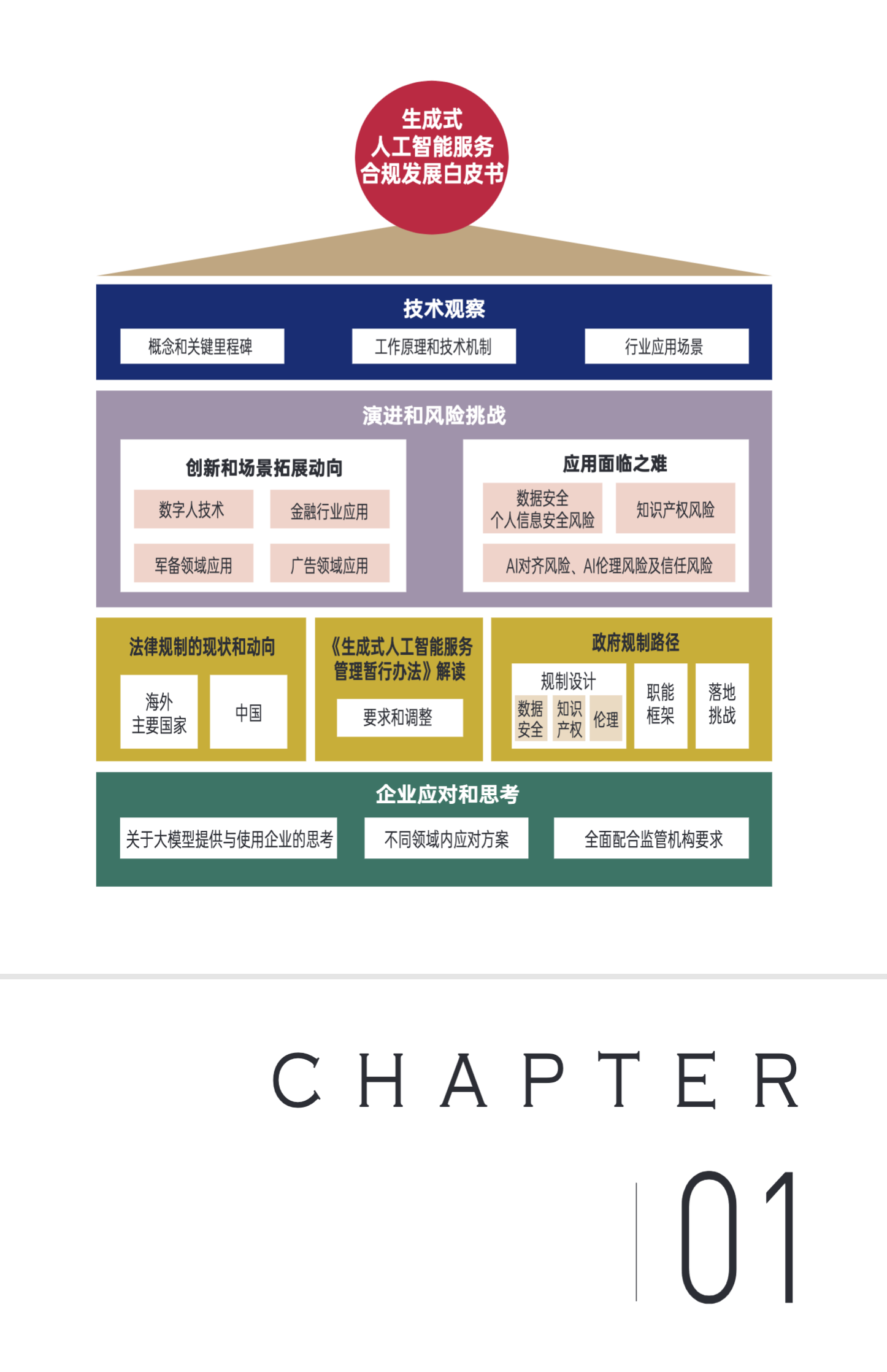

生成式人工智能的概念和关键里程碑

生成式人工智能AIGC与PGC(Professional Generated Content,专业生成内容)、UGC(User Generated Content,用户生成内容)相对应,指利用人工智能(Artificial Intelligence,AI)技术可根据用户需求自动生成与之匹配的内容。只需输入要求,生成式人工智能即可帮助创作者自动生成所需内容,创作者可花费更多时间进行主题构思并减少实际创作时间,提升工作效率和创作质量。生成式人工智能表现为一种高效的商业化内容生产方式,目前AI仍为内容制作的辅助型角色,待技术突破后AI可真正作为内容创作者,即生成式人工智能。

人工智能的发展时期主要经历了四个阶段,在其发展过程中,AIGC的根本动力和逻辑都与互联网的发展紧密相连,最终落实到算力和数据两大基石的不断扩张。

第一阶段为AI诞生以及规则驱动时期(1943-1980s)。该阶段主要为人工智能概念的诞生和方法论构建,受限于当时的科技水平,仅限于科研实验室内的小范围实验。1950年,艾伦·麦席森·图灵(Alan Mathison Turing)提出了“图灵测试”,其目的是检验机器是否可以表现出与人类难以区分的智能,这一想法引发了机器产生智能的探讨。1956年的达特茅斯会议首次提出了“人工智能”概念和理论,核心在于如何让机器使用语言、进行抽象思考和形成概念,让它们解决目前只能由人类解决的问题,并自我改善。这次会议后人工智能领域逐渐发展出符号学派、联结学派(神经网络)等分支,围绕如何构造人的智能连接进行了探索,重要成果包括了机器定理证明、跳棋程序和人机对话等。1957年Frank Rosenblatt设计了第一个计算机神经网络“感知机”,它被认为是第一个成功应用神经网络原理解决实际问题的算法。1958年赫伯特·西蒙和艾伦·纽厄尔演示了一个名为“逻辑推理家”的软件,被认为是第一个成功设计的人工智能程序。1966年约瑟夫·魏鲍姆和肯尼斯·科尔比共同开发了第一款可人机对话的机器人“伊莉莎 (Eliza)”,其通过关键字扫描和重组完成交互任务。从上面的研究结果可以看出,早期探索阶段主要围绕如何模拟人类思维展开,通过人工设计规则来实现预定目标。

第二阶段为知识系统时期(1980s)。该阶段人工智能不仅局限于通过模式化的算法逻辑解决问题,还需要通过自主学习去研究问题。标志是1977年世界人工智能大会上“知识工程”概念的首次提出,由此传统架构逐渐发展成专家系统架构,它是一种基于“规则+知识”的人工智能技术,试图模拟专家在某个特定领域内做出决策的过程。这种系统通常由两个主要部分组成:知识库和推理引擎。知识库包含了专家在特定领域内的经验和知识,通常以规则、事实、关系和概率等形式表示。推理引擎则负责从知识库中提取信息,分析数据,应用推理规则,并生成结论或建议。在这个时期,专家系统在医疗、工业、金融等领域得到广泛应用,主要以大学实验室的专家系统为主。在技术手段方面,算力也在不断提升。80年代,IBM基于隐形马尔科夫链模型(Hidden Markov Model)创造了语音控制打字机“坦戈拉(Tangora)”,它能够处理约20000个单词。人工智能的研究方法也从逻辑推理、搜索算法等领域扩展到了知识表示、推理和学习等多个方面。

第三阶段为机器学习时期(1990s-2010)。在Web1.0的推出和Web2.0的持续演化发展过程中,该时期体现了互联网商业化渠道的打通和机器学习的初步探索。此时互联网的网站通常采用静态HTML页面,这些页面是由网站开发者手动编写的,用户只能被动地接受网站提供的信息。在此背景下,机器学习作为探索行业痛点的解决方案之一被提出,它利用算法和统计模型来使计算机在没有明确编程的情况下自动学习,通过对大量数据进行学习,从而归纳出数据中的规律和模式,最终将这些应用于新的数据中以实施预测或分类任务,具体方法包括支持向量机、决策树、朴素贝叶斯等。此时人工智能的商业化能力已基本兑现,但渠道还未铺开。1997年IBM开发的超级电脑“深蓝”战胜了国际象棋世界冠军卡斯帕罗夫,2006年谷歌领导的自动驾驶汽车项目开展,宣告着人工智能商业化规模效应已初步呈现。进入2000年代中后期,社交网站时代用户生成内容(UGC)的产生社交网络的发展和个性化定制的不断挖掘均为机器学习的深度发展奠定了坚实基础。整体而言,该阶段并没有很多清晰、具体的落地成果,但伴随互联网行业的发展提升,其发展前景越发清晰。

第四阶段为深度神经网络时期(2011年至今)。该阶段的核心特点是深度学习方法的迭代更新和商业化的广泛运用。算法上,生成式对抗网络(GenerativeAdversarial Network,GAN)极大提高了内容生成质量,应用场景拓展到语音处理、图像分类、视频处理、无人驾驶、交互问答等多场景。2011年IBM的Watson在美国电视智力竞赛节目《危险边缘》(Jeopardy!)中战胜人类选手获得冠军。同年苹果推出Siri作为iPhone的自然语言问答工具。2015年马斯克联合山姆·奥特曼等人共同创建OpenAl,主要目标为制造“通用”机器人和使用自然语言的聊天机器人,GPT初代模型随后研发产生。2016年谷歌旗下DeepMind公司推出的阿尔法围棋(AlphaGo)战胜围棋世界冠军李世石。2017年微软人工智能少女“小冰”推出了世界首部100%由人工智能创作的诗集《阳光失了玻璃窗》。2018年谷歌基于基础自然语言模型(NLP)发布了自然语言生成模型BERT。2022和2023年OpenAl先后发布了GPT-3.5和GPT-4,带动生成式人工智能走向新的高潮。如今互联网数据已经不仅限于简单的文本和图片,而是变为了语义化的数据,可以被计算机深入理解和处理,从而实现更高效的信息管理和应用。

生成式人工智能的工作原理和技术机制

生成式人工智能是一种技术集合,它基于生成对抗网络(GAN)和大型预训练模型等人工智能技术,利用已有数据来寻找规律,并通过适当的泛化能力来生成相关内容。根据监督学习的方法差异,机器学习领域具有判别式(Discrimina-tive)和生成式(Generative) 两种典型模型:判别式模型是对条件概率建模,学习不同类别之间的最优边界,从而完成分类任务;生成式模型则面向类建立模型,计算基于类的联合概率,然后根据贝叶斯公式分别计算条件概率,进而根据输入数据预测类别。GAN模型出现后,人们开始利用生成式机器学习模型实现文本、图像、语音等内容的智能合成,学术界将其定义为生成式AI(Generative AI)。

算法端方面,人工智能的两个重要阶段为机器学习和深度学习,机器学习主要以神经网络为标志,深度学习则在神经网络基础上构造更深层次的结构对更高维度的数据进行学习。同时这两者可以相互结合,称为深度强化学习(DRL)。

时间方面,神经网络的概念出现较早,在人工智能概念提出前的1943年就已经具有雏形。1943年,心理学家麦卡洛克(McCulloch)和数学家皮茨(Pitts)最早将生物学中的神经网络中的最基本的成分-“神经元模型”抽象为简单模型,即MP模型。该模型中,神经元从其他神经元或外部环境接收二进制输入并加权相加,将结果与闽值进行比较。如果输入的总和超过阑值,则神经元发射,产生1的二进制输出,否则神经元保持不活动,产生0的输出;由于它只能表示二进制的输出结果,局限性较大。1986年,辛顿(Hinton)以此为基础提出第二代神经网络,利用误差的反向传播算法来训练模型,算法效率大幅提升;算力上通过并行计算和GPU加速等技术,已实现可以处理更大规模的数据和更加复杂的问题。1989年,Yann LeCun等提出LeNet-5模型已实现数字识别。1997年,长短时记忆网络(LSTM)作为循环神经网络(RNN)的改进型被提出,主要用于解决传统循环神经网络中遇到的梯度消失和梯度爆炸问题,使得神经网络可以更好地处理长序列数据。2006年,辛顿首次提出了深度置信网络(Deep Belief Network,DBN),它的训练分为无监督预训练和有监督微调两个阶段,其中对无监督特征的强调成为深度学习的雏形。2014年,新的生成对抗网络(GAN)被提出,它的基本思想是将生成器网络和判别器网络同时进行训练,通过竞争来逐步提高生成器网络的生成能力。训练过程进化为生成器网络的训练和判别器网络的训练两个阶段,通过对真假不断判断和挑战提高相关精度。该阶段在商业化的里程碑事件就是2016年Alpha-Go击败围棋世界冠军李世石,表明了算法在商业化落地后的巨大力量。

随后,模型的发展方向主要聚焦长序列的处理和计算效率的提升,代表就是2017年谷歌Transformer模型的发布。它是一种基于自注意力机制的编码一解码模型,解决序列到序列(Sequence-to-Sequence)学习任务中的长序列问题,例如机器翻译、语音识别、文本摘要等任务。2017年6月,Google Brain在神经信息处理系统大会(NeurlPS)发表论文《Attention is all you need》,首次提出了基于自我注意力机制(self-attention)来提高训练速度的Transformer模型,将其用于自然语言处理。Transformer由编码器和解码器两部分构成,其中编码器用于将输入序列转换为一系列特征向量,解码器则将这些特征向量转换为输出序列。编码器和解码器都由多个相同的层次组成,每个层次包含多头注意力机制(Multi-Head Attention)和全连接前馈网络(Feed-Forward Network)两个子层次。该架构的优点是可以并行处理输入序列的所有元素,能够捕捉长距离的依赖关系,此架构奠定了大语言模型(LLM)的强大基础。

生成式人工智能的基础架构是大语言模型。它是在大量数据集上进行预训练,且没有针对特定任务调整数据,另外可以对自然语言进行建模,以便于生成文本、语音识别、文本分类、机器翻译等任务。它的优点在于可以生成高质量的自然语言,同时还可以理解和处理复杂的语言结构。其路线主要分为三种:1)编码器路线;2)编解码器路线;3)解码器路线。三条线在发展初期都处于各自探索阶段,但2020年GPT-3模型的编译及其表现出的优异性能,解码器逐渐占据主导优势。同时模型闭源逐渐成为头部玩家的发展趋势,包括Google、OpenAI、META(原Facebook)等公司都在推进。

在算法端,Transformer的自注意力机制是特殊情况下的注意力机制。在一般任务的编码一解码(Encoder-Decoder)框架中,输入(Source)和输出(Target)内容是不一样的,例如对于英一中机器翻译来说,输入是英文句子,输出是对应地翻译出的中文句子。注意力机制发生在输出的元素Query和输入中的所有元素之间。而自注意指的不是输入和输出之间的注意力机制,而是输入内部元素之间或者输出内部元素之间发生的注意力机制,即“Target=Source”这种特殊情况下的计算机制。自注意力机制更容易捕获句子中长距离的相互依赖的特征,且对于增加计算的并行性也有直接帮助作用。OpenAl的GPT系列模型均是基于Google提出的Transformer模型的解码器(Decoder)架构,每代模型仅对架构进行微调。从模型参数量和训练数据集维度看,在GPT-3模型之前,参数量和训练数据量均呈现快速增长态势,尤其是GPT-3模型参数量为1750亿,达到阶段性巅峰。

最新框架中,指示学习(lnstruction tuning)成为下一步发展的方式,其最早由2022年论文《Finetuned Language Models Are Zero-Shot Learners》提出论述。该模型需要学习如何在给定的输入条件下,输出与专家行为相似的结果,较类似于人类学习新技能的方式,例如观察和模仿专家的行为,从而逐渐掌握新的技能。此外,指示学习还可以避免一些传统强化学习方法中的问题,例如训练不稳定、难以收敛等问题。

中国在生成式人工智能法律规制方面的现状和趋势

人工智能在中国 的发展已经过去了20余年。在此期间,人工智能技术在中国的应用场景逐步拓展, 为中国的数字经济高速发展注入了新的活力。 虽然在人工智能发展初期,中国对人工智能的监管处于相对空白的状态。然而,随着技术的发展,一系列与人工智能相关的法规已经开始涌现。在新一轮科技革命和产业变革深入发展的背景下,中国的人工智能发展已经 进入到了一个全新的阶段。在未来,中国将继续完善人工智能的法规体系,更好地 推动人工智能的健康发展。

生成式人工智能可以极大降低内容生产和交互的门槛和成本,在日新月异的高速发展中,有望带来一场自动化内容生产与交互变革,为各行业发展赋能。全览其发展趋势,可以归结为“亦巨亦微”。巨大模式是全模态和海量参数,是从大数据到全数据的发展趋势;小微模式是模型压缩和优化,力争在有限资源达成近似性能。

2023年3月14日发布的GPT-4采用了更多更为丰富的训练数据,拥有更高的理解能力和更专业的判断水平,其预估参数相较GPT-3的1750亿参数量,增加了数十倍不止。同时,在确保保持高预测准确性的前提下,大幅度降低模型的大小和计算成本,优化计算效率,实现高效的模型预测,此类研发可以在较小的设备上进行研发。2023年3月,斯坦福发布了轻量级语言模型Alpace,该模型在LLaMA的基础上加入指令Alopace。其可以在笔记本电脑上进行部署,甚至可以在手机上进行运行,并且丝毫不会因为设备不同而影响其性能,依旧在性能方面可媲美GPT-3.5这样的超大规模语言模型。

生成式人工智能虽然在众多行业中实现了革命性的突破,为业务带来了前所未有的便利与效率,但同时也伴随着一些不可忽视的风险。

生成式人工智能的创新和场景拓展动向

生成式人工智能的创新和应用场景已经遍地开花,包括工业领域的设计、建模检测;医疗领域的药物发现、诊断治疗;教育领域的课程训练、智能助教;电商领域的商品定向推送、虚拟主播;传媒领域的新闻采集、快速剪辑:社交娱乐领域的人脸替换、智能抠图;创作领域的剧情脚本生成等。本节中针对主要拓展场景进行探讨。

1.数字人技术的运用

星愿航天的数字生命计划,致力于为唐氏综合征患者和自闭症患者建立数字人,帮助他们实现自己的梦想,提高社交能力,建立自信心,以及辅助康复。星愿航天利用数字复原技术为患者创建了一个数字化的“自我”,结合了先进的AIGC技术,使得患者能与其数字化的“自我”对话,这成为一种新的心理治疗手段数字人技术为我们揭示了数字化人类的可能性,重塑了信息技术与生命之间的联系。

2.金融行业的运用

类似ChatGPT的基于生成式人工智能的技术应用,具备高度的自然语言识别和写作能力,能够根据特定的对话指令快速生成多种类型和风格的内容,包括纯文本、图文、精美的图片、动画、短视频等。不仅如此,随着对话的深入人工智能可更好地理解用户的意图,从而生成更加精准的内容。此类特性有助于不断发掘用户的深层需求。

目前,生成式人工智能已成为金融行业中备受瞩目的技术之一,尤其在保险业中发挥了其显著作用。观察保险产品的设计至实施全流程,涉及众多信息收集、数据处理、精算和风险评估的步骤。这些过程中过去常依赖于繁琐的手动检索、计算和经验判断。但如今,尤其是健康险、寿险等人身险领域和财产险领域中,生成式人工智能模型独特的样本生成能力和场景泛化能力可以发挥巨大作用,将贯穿产品、营销、运营和客服等全流程,提供深度技术赋能。

客户发掘和方案制定阶段,新保险产品的设计通常面临非结构化、半结构化数据的收集和处理问题。相对于传统的机器学习模型,即使面对非标格式的电子病历、医学文献和药物数据等内容,生成式大语言模型都可以大幅提高数据处理效率。

借用智能客服等功能,通过“指令”、“提示”等少样本学习可以完成特定信息抽取、格式转化任务,多模态模型对图像、文本、音视频数据的融合处理能力可极大降低对人工标注数据的依赖。同时,样本信息抽取能力还可以转化为定制数据处理模型的训练数据标注来源,为后续工程构建更精准的小型模型。

对于保险产品文档等物料生产环节,与抽取的非结构化、半结构化数据相对应,产品设计完成后可以直接形成保险范围、保险责任、费率表、免责约定等商务条款,快速生成对应的文档、图像宣传物料等。

保险产品风险评估和精算预测阶段,凭借生成式人工智能生成的自然语言摘要、说明模型预测结果和变量权重等功能,可以快速提炼可视化的数据结果,更好解释并支持商业决策和产品设计。例如:分析健康险数据(含历史赔付数据、人口统计和医疗资料等),结合个人医疗历史和记录,在不同的场景下模拟赔付情况以便更好地了解产品可能面临的风险和挑战,提升产品的可靠性和稳定性。

保险投资阶段,可通过智能工具进行数据分析,提高风险控制能力,为投资组合决策提供参考意见。

金融作为实效性要求最高的服务业,生成式人工智能的落地和不断学习发展将成为必然趋势,集中体现在金融类产品(SAAS支付等)的入口重塑,同时在金融垂类细分领域作为AI智能助手,提供更准确、有效、及时的信息。作为金融平台龙头,彭博社重磅发布为金融界打造的大型语言模型BloombergGPT,并构建了一个3630亿个标签的特定领域数据集FINPILE,训练专门用于金融领域的LLM,以支持金融行业内的各类任务。该模型在金融任务上的表现远超过现有模型,在NER(Named Entity Recognition)中排名第二。

生成式人工智能应用面临之难

对于生成式人工智能的天然风险,社会各界已逐渐形成了一定共识,包括误导欺诈性风险、缺乏可解释性风险、数据安全风险、隐私泄露风险、知识产权风险和侵害消费者权益等。

对于生成式人工智能运用过程中的风险,AI对齐是一个值得探究的问题,即使用和开发的人,是否会出于一己私欲滥用AI,从而出现宗教信仰、性别、性取向.政治立场不同下的算法歧视,引发社会仇恨言论等。此外,大量算力使用下形成的超高能源消耗,也给环境保护带来挑战

对于应用维度之上的哲学思辨范畴,人工智能从诞生之日起便不断引发人类对其伦理困境的探讨,包括AI本身可能会形成自我意识,以及其意识的价值观伦理观可能与人类相悖

尽管ChatGPT属于文字类应用,但其具备生成式人工智能服务的所有特点和行业的代表性,我们以该产品为例探究AIGC应用中的风险敞口。

深化生成式人工智能规制设计

生成式人工智能虽然发展迅猛,但是受限于法律的滞后性,仍然有大量的内容有待立法探寻确认,例如:生成式人工智能因固有缺陷导致的侵权、服务提供者与用户共同作用下的侵权等情形下责任的承担方式,或者特殊人群(包含老年人、残疾人、精神病人、未成年人等)在使用生成式人工智能时的权益保障等。

目前,我国的民法、刑法和行政法等基本法能在一定程度内对生成式人工智能进行分散治理,但法律体系尚未形成,主要表现为对底层技术治理不足、对技术提供者监管不充分,数据与场景分类分级标准繁杂且未形成体系,相应的规则过于分散。同时,在生成式人工智能的现有理论研究中,人工智能的法律主体地位和人工智能生成物的法律地位是核心场景,但研究场景多样化。总体上看,生成式人工智能对现有数据、算法等分而治之的不成体系的治理范式提出了严峻挑战,与网络安全、数据安全、个人信息保护、数据跨境流动等现有制度存在不适恰性,生成式人工智能的治理范式、现有制度和理论均存在缺失,因此搭建生成式人工智能的综合监管框架显得尤为必要。