2023年全球生成式ai产业研究报告

生成 AI 和 ChatGPT 企业风险

高管 , 其中包括 CISO , 发现自己落后于 技术采用曲线 , 而员工和业务部门 正在迅速采用生成人工智能 (GenAI) 技术。

CISO 提出的关键问题是 : 谁在我的组织中使用这项技术 , 目的是什么 ? 当员工与 GenAI 互动时 , 如何保护企业信息 ( 数据 ) ? 我管理底层技术的安全风险 ? 如何平衡 s 与

ER 技术的价值 ?

• 通过为组织制定定制政策 , 可以管理与 GenAI 相关的风险 , 在 与相关利益相关者合作。

虽然 GenAI 固有的许多风险存在于任何基于云或 AI / ML 的技术中 , 但新的政策 假设需要广泛采用 GenAI , 包括非技术人员。

• 企业中与 GenAI 相关的最严重的风险来自四个潜在问题 : > GenAI 对内部运营和流程的影响。

> 信任第三方安全的必要性。

›

数据泄漏风险虽然确实存在 , 但在媒体上被不必要地炒作。

• These risks can be managed by the application of following strategies:

> 识别相关风险及其对组织的影响 ;

> 设置组织政策 , 说明如何以及谁可以使用这些工具 , 以缓解上述问题

风险达到可接受水平 ;

> 根据其安全性和策略可定制性选择合适的 GenAI 提供商 客户 , 例如选择退出和数据保留 , 以及 ;

> 检查企业控制下的潜在本地替代品。

许多企业及其员工已经在使用 ChatGPT ,

Bard 、 PaLM 、 Copilot 和其他生成 AI (GenAI) 或大型 语言模型 (LLM) 和 CISO 现在正在使用其 团队识别和评估相关企业风险。We will 在本文中将各种技术和模型称为 “GenAI ”

为了简单。

GenAI , 特别是 ChatGPT , 作为强大的工具在企业中越来越受欢迎 简化通信 , 编写代码 , 生成图像 , 音频和视频 , 增强客户

服务 , 撰写文件并进行初步研究 , 并在其他日期进行改进 - 今天的活动。

然而 , 与任何技术一样 , GenAI 的使用也会带来一系列的安全风险、威胁和 组织必须仔细考虑的影响。

GenAI 一直是安全领域的首要问题之一 高管们在 2023 年前几个月 , 并且一直是 由我们的 Team8 CISO 村社区的成员优先考虑 制作关于这一主题的联合文件。

CISO 提出的关键问题是 : 谁在我的组织中使用这项技术 , 目的是什么 ? 当员工与 GenAI 互动时 , 我如何保护企业信息 ( 数据 ) ? 管理底层技术的安全风险 ? 如何平衡 s 与

重视ER的技术?

本文档提供了有关风险的信息 , 并建议了安全团队和 CISO 的最佳实践 可以在自己的组织中利用 , 并作为社区传福音的行动号召 并进一步参与该主题。

• 我们将探索潜在的风险和威胁与在企业环境中使用 GenAI 相关 , 专注于技术方面 , 以及由此产生的一些法律和监管风险。 我们将进一步讨论威胁建模 , 参与工程团队以及内部部署或开源 替代品。

• 我们将提供可操作的建议企业如何才能全面

方法 , 包括制定组织政策和行动计划 , 以及样本政策 , 这样他们就可以确保他们以安全和安全的方式使用 GenAI 。

不幸的是 , 许多 CISO 发现自己在

GenAI 采用曲线和风险被视为业务障碍 而不是业务推动者。因此 , CISO 可能会感到压力 广泛允许 GenAI , 但不分青红皂白地这样做可能会创造 不合理的风险。

除了使企业达到 GenAI 使用标准 , 制定书面政策 , 以及

实施安全控制 , 作为安全领导者 , 我们有一个独特的机会来促进和实现 企业通过安全可靠的技术创新。

考虑到 GenAI 为所有企业提供的生产率提升 , 组织需要

business - enabled alternative to rejection the use of the technology totally. Organizations that have 最初实施这样的限制 , 最近一直在重新考虑他们的立场和解除

批发禁令。

不断演变的 CISO 角色

CISO 角色需要不断发展 , 以适应新的企业风险 , 特别是考虑到发展

在这方面的监管。

在制定欧盟人工智能法案的背景下 , 一些人将 CISO 描述为 “信任大使 ” 。 CISO 组织的潜力现在被认为是开发更广泛的风险方法的催化剂 包括对数据收集、使用、治理和基础架构的额外强调。

这些是 CISO 的责任领域 , 他们通常不拥有完全或任何权力 , 技术风险素养 , 并能为企业使命提供实质性支持。他们也可能 要求承担一定程度的责任。

作为对业务和技术都有了解的高级管理人员 , CISO 很好 定位帮助组织驾驭这项新技术带来的风险和机遇

面临历史性机遇

CISO 社区面临着一个历史性的机遇 全球个人的安全和隐私 , 超越我们的 组织。

当新技术被引入世界时 , 安全和隐私通常是事后的想法 , 无论是由于商业激励、预算和资源问题 , 还是仅仅是由于 创新。

事实上 , 这在社交媒体、云、智能手机和许多其他技术之前也发生过。 在采用周期的后期引入了安全性和隐私 , 而不受控制

使用量猛增。

作为一个集体 , CISO 社区有能力塑造最佳实践并影响未来 这些工具的开发 - 今天 , 随着个人的安全和隐私 , 以及我们的组织 , 在心里。

最后 , 在 Team8 CISO 村 , 我们正在规划未来 关于这个主题的合作项目

The Changing 威胁景观

每个人 , 包括 OpenAI 等 GenAI 开发人员 , 仍然 了解技术的全部潜力。虽然一些威胁

看起来很明显 , 与我们之前看到的相似 风险名单仍然未知。

GenAI 迅速引入了新的安全风险 , 因为它 普遍性、易用性、高价值主张和巨大 潜在的业务支持价值。

作为其快速采用曲线的一个例子 , ChatGPT 在两个月内达到了 1 亿用户 , 订单为 比以前的任何技术都快。

与传统的 AI / ML 技术相比 , GenAI 更易于使用 :

• 直观的互动和新颖的内容生产模式- AI 中的一种新方法与 交互式聊天系统 , 提供 “抛光 ” 结果。最终用户能够在 聊天界面比早期平台更容易提高未来的准确性。

• 所有人都可以访问- 许多 GenAI 技术是免费或低成本的 , 向公众开放 , 并且可以访问 任何有互联网连接的人。

• Ease of use- 许多 GenAI 技术被设计为所有职位和职位的人都很容易 角色 , 使用自然语言 , 就像与另一个人交谈一样。

• 速度和敏捷性- 系统可以比以前更快地生成信息 , 源代码和数据 可能通过手动搜索 , 查询和索引。它可以合成数百万页的信息 成一个段落。

• 与第三方应用程序集成- 许多当前的日常应用程序 , 如 Microsoft

冰 365 套件的工具和浏览器插件 , 指向一个现实 , 即 GenAI 将在我们的 日常生活。

新企业风险 由 GenAI 介绍

了解企业环境中潜在的 GenAI 风险、威胁和影响的范围已成为

a priority, and must be carefully considered. These can be broken down to technological or process 现有风险、法律和监管风险以及一些全新风险的延伸。

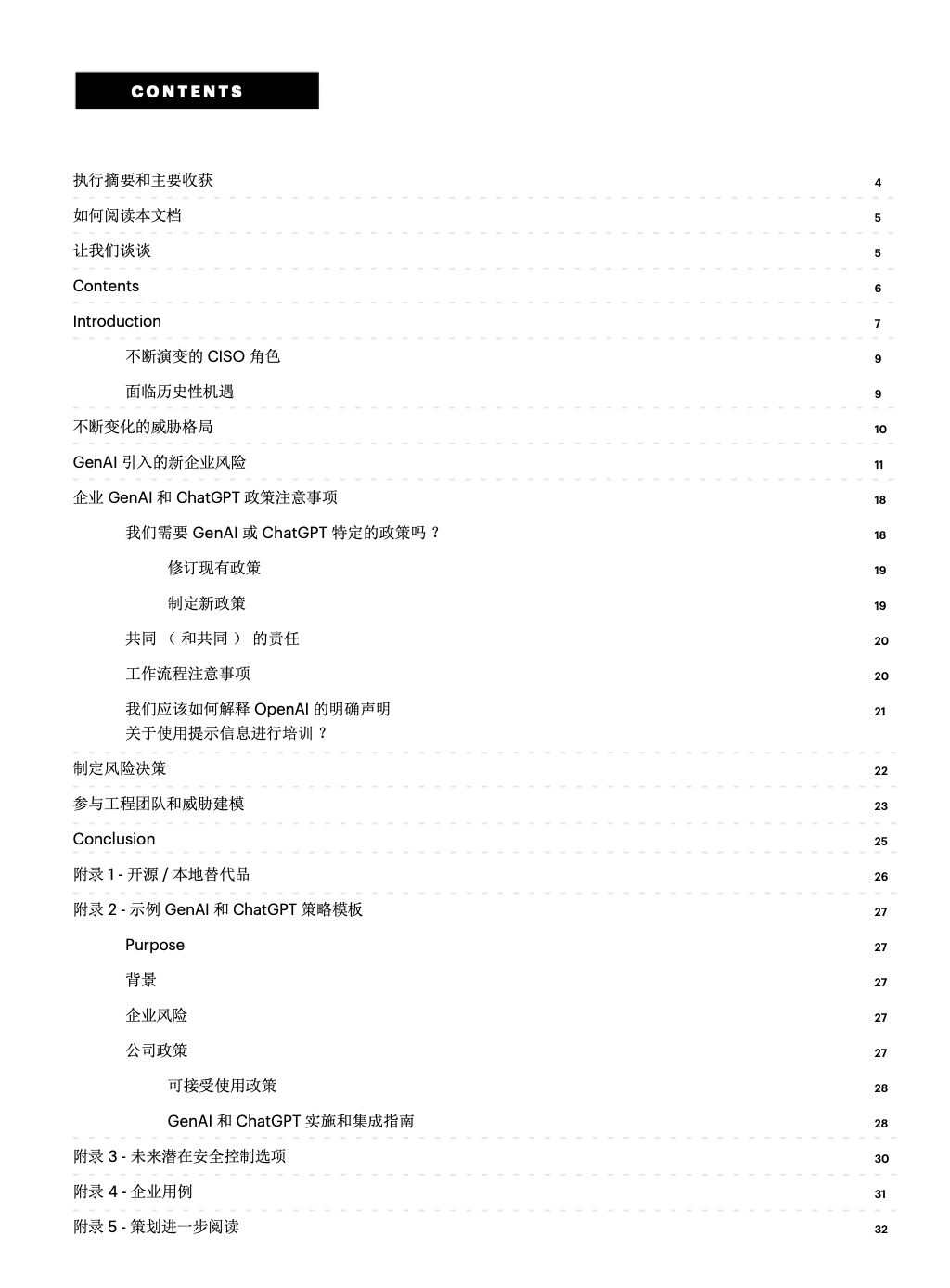

为了提供这些风险的概述,我们在下面创建了参考表,并按

风险水平 , 截至 2023 年 4 月 (免责声明 : 每个组织都是独一无二的 , 这些都是 ered 作为指导方针) 。

企业可以采取积极措施 , 最大限度地减少 GenAI 使用的潜在负面影响 , 并 确保他们以安全、合规和负责任的方式利用这一强大的工具。

例如 , 组织could决定在将数据发送到第三方 GenAI SaaS 平台时 , 选择退出用于训练未来模型的用户提示信息 , 并接受数据

30 天的保留政策 (就像 OpenAI 的情况一样) , 足以满足他们的需求和 满足他们的风险偏好。

其他人可能决定宣布风险例外并接受风险 , 或决定探索内部

alternative.

由于媒体的炒作 , 作者和贡献者希望专门解决数据暴露风险

与 GenAI 相关 , 特别是与 ChatGPT 相关 , 使用户输入和专有数据可供 非预期的受众 , 如竞争对手。在撰写本文时 , 大型语言模型 (LLM) 不能 实时更新自己 , 因此不能将一个人的输入返回到另一个人的响应 , 有效地揭穿了这一担忧。

然而 , 对于这些模型的未来版本的训练来说 , 这并不一定是正确的。GenAI 技术将来可能会使用提交的内容来改进其算法和模型。我们触摸 关于这种风险及其可能性 , 以及特别是 OpenAI 在利用用户输入模型方面的立场 培训 (选择退出此类使用、数据保留限制、用户输入有偏见模型的挑战、

等) 在下表中 , 以及本文档的后面部分。

威胁 : 非公有企业和私有数据

Data

隐私和

Confidentiality

企业使用 GenAI 可能会导致敏感的访问和处理 信息、知识产权、源代码、商业秘密和其他

数据 , 通过直接用户输入或 API , 包括客户或私人 信息和机密信息。这已经报告给

这是一个问题 , 在这里。

法律考虑咨询律师

在组织的外部发送机密和私人数据

自己的服务器 , 与云一样 , 可能会触发合法的

和合规性风险 ,以及信息暴露的风险。这样的

风险可能来自合同 (例如与客户) 或监管

义务 ( 例如 CCPA , GDPR , HIPAA ) 。下面的讨论重点介绍了这些 支持知情风险管理和缓解的风险敞口类型

措施。

• While data sent to GenAI technologies such as ChatGPT has been effectively 委托给第三方 SaaS , 即 OpenAI (另请参阅 “第三方风险

和此表的 “数据安全 ” 部分) ,它目前没有合并

进入 LLM 实时 , 因此不会被其他用户看到。GenAI 平台可能会选择使用用户输入来训练未来的模型 , 但 现在似乎不是这样。查看更多关于这个以及我们为什么要这样做 这里的差异。

• 根据公司文档 , 特别是在 OpenAI 的情况下 ,

提交给其 API 的内容不会保留超过 30 天 , 并且

默认情况下是选择退出 , 而 ChatGPT 默认情况下是选择加入和选择退出 基于费用的帐户。尽管如此 , 提交的信息始终是主题 存储和处理风险。但是 , 这可能会影响

不同的组织。